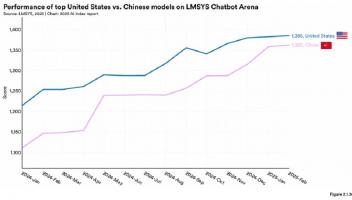

从数月到几天:OpenAI 安全测试漏洞引关注,AI 竞赛暗藏危机

随着人工智能(AI)技术的飞速发展,大型语言模型(LLM)如OpenAI的最新o3模型的安全性问题逐渐引发关注。从数月到几天的时间压缩,OpenAI的安全测试漏洞引发了业界和公众的广泛讨论。本文将从专业角度分析这一现象,并提出应对策略。

一、竞争驱动,安全让步

近期有八位知情人士透露,OpenAI在推出新模型以维持市场优势的过程中,大幅压缩了模型的安全测试时间。留给员工和第三方测试团队“评估”时间仅有数天,而此前通常会耗时数月。这种时间上的急剧压缩,无疑给安全测试带来了巨大的挑战。

二、测试不足,监管缺位

目前全球尚未统一AI安全测试标准,但欧盟《AI法案》将于今年晚些时候上线,要求企业对其最强大的模型进行安全测试。然而,由于缺乏强制监管,企业不会主动披露模型的危险能力,竞争压力进一步加剧了风险。

三、OpenAI的应对策略及其问题

面对竞争压力,OpenAI推出了o3模型,并计划最早下周发布。然而,在测试期长达六个月的情况下,留给测试者安全检查时间不到一周,这无疑暴露出其应对策略的问题。此外,OpenAI对较老旧的模型进行有限微调,而最新模型如o1和o3-mini未全面测试,这进一步加剧了风险。

四、公众知情权与责任

前OpenAI安全研究员Steven Adler批评,若不兑现测试承诺,公众有权知情。这意味着,在AI竞赛日益激烈的今天,企业和研究机构有责任向公众透明地披露模型的潜在风险和危害。

五、解决之道:建立强制性的AI安全测试标准

为了应对这一挑战,全球各国应尽快建立强制性的AI安全测试标准,以规范各企业在推出新模型时的安全测试行为。此外,监管机构应加强对AI企业的监督,确保其遵守相关法规,并公开披露模型的潜在风险。

六、技术进步与伦理责任并重

在技术不断进步的同时,我们不能忽视伦理责任的重要性。企业和研究机构在追求技术突破的同时,应始终将用户安全、数据隐私和道德伦理放在首位。我们期待看到一个更加负责任的AI发展环境,让技术进步真正服务于人类社会。

总结:

大型语言模型(LLM)如OpenAI的o3模型的快速推出引发了业界和公众的关注。然而,安全测试时间的大幅压缩和测试不足的问题不容忽视。我们需要建立强制性的AI安全测试标准,以规范各企业在推出新模型时的安全测试行为。在AI竞赛日益激烈的今天,企业和研究机构有责任向公众透明地披露模型的潜在风险和危害。让我们期待一个更加负责任的AI发展环境,让技术进步真正服务于人类社会。

(免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。 )