极客网·人工智能5月30日 深度求索(DeepSeek)公司5月28日宣布DeepSeek-R1进行了小升级,引发广泛关注;29日官方详细介绍了此次更新的变化,称当前版本为DeepSeek-R1-0528,升级后的新模型在深度思考、推理能力、幻觉改善、创意写作等方面有了较大的提升。

特别地,新版DeepSeek R1针对“幻觉”问题进行了优化。与旧版相比,更新后的模型在改写润色、总结摘要、阅读理解等场景中,幻觉率降低了45~50% 左右,能够有效地提供更为准确、可靠的结果。

深度思考能力强化

DeepSeek-R1-0528仍然使用2024年12月所发布的 DeepSeek V3 Base 模型作为基座,但在后训练过程中投入了更多算力,显著提升了模型的思维深度与推理能力。

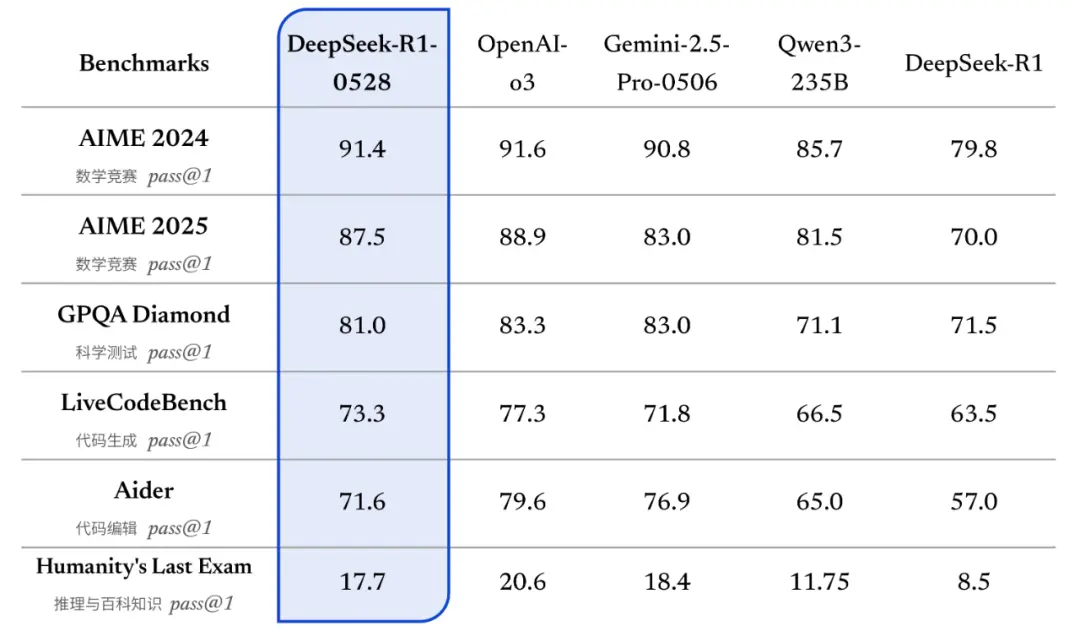

更新后的R1模型在数学、编程与通用逻辑等多个基准测评中取得了当前国内所有模型中首屈一指的优异成绩,并且在整体表现上已接近其他国际顶尖模型,如o3与Gemini-2.5-Pro。

DeepSeek-R1-0528 在各项评测集上均取得了优异表现(基准测试使用 64K 输出长度;在 Humanity's Last Exam 中,只使用其中的文本题目进行测试)

相较于旧版 R1,新版模型在复杂推理任务中的表现有了显著提升。例如在 AIME 2025 测试中,新版模型准确率由旧版的 70% 提升至 87.5%。这一进步得益于模型在推理过程中的思维深度增强:在 AIME 2025 测试集上,旧版模型平均每题使用 12K tokens,而新版模型平均每题使用 23K tokens,表明其在解题过程中进行了更为详尽和深入的思考。

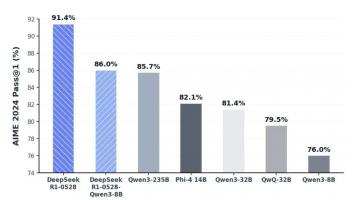

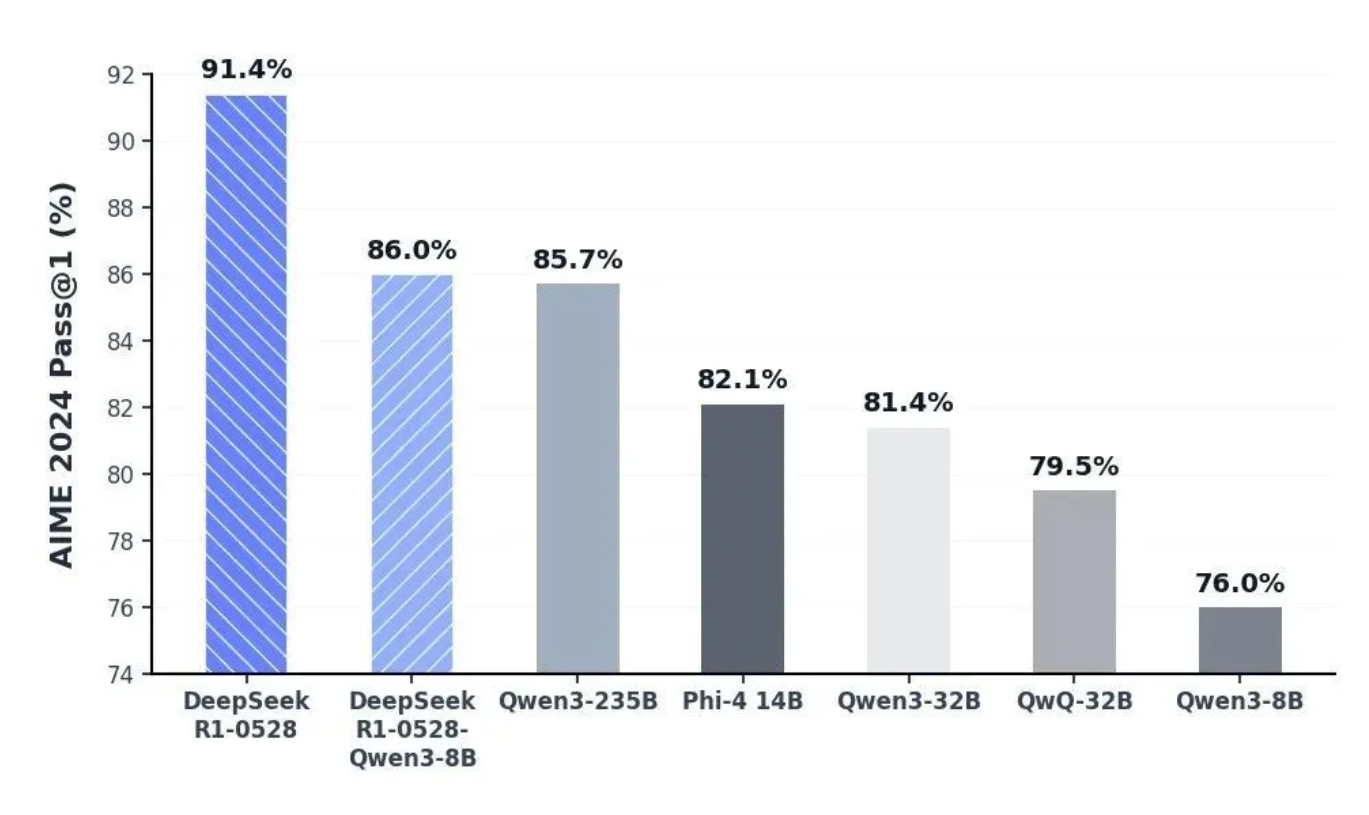

同时,蒸馏DeepSeek-R1-0528的思维链后训练Qwen3-8B Base,得到了 DeepSeek-R1-0528-Qwen3-8B。该8B模型在数学测试AIME 2024中仅次于DeepSeek-R1-0528,超越 Qwen3-8B (+10.0%),与 Qwen3-235B 相当。DeepSeek-R1-0528的思维链对于学术界推理模型的研究和工业界针对小模型的开发都将具有重要意义。

DeepSeek-R1-0528-Qwen3-8B 等开源模型的 AIME 2024 对比结果

DeepSeek-R1-0528-Qwen3-8B 等开源模型的 AIME 2024 对比结果

其他能力更新

幻觉改善:新版DeepSeek R1针对“幻觉”问题进行了优化。与旧版相比,更新后的模型在改写润色、总结摘要、阅读理解等场景中,幻觉率降低了45~50% 左右,能够有效地提供更为准确、可靠的结果。

创意写作:在旧版 R1 的基础上,更新后的 R1 模型针对议论文、小说、散文等文体进行了进一步优化,能够输出篇幅更长、结构内容更完整的长篇作品,同时呈现出更加贴近人类偏好的写作风格。

工具调用:DeepSeek-R1-0528 支持工具调用(不支持在 thinking 中进行工具调用)。当前模型 Tau-Bench 测评成绩为 airline 53.5% / retail 63.9%,与 OpenAI o1-high 相当,但与 o3-High 以及 Claude 4 Sonnet 仍有差距。

示例为通过 LobeChat 使用 DeepSeek-R1-0528 的工具调用能力得到的网页文章总结

此外,DeepSeek-R1-0528 在前端代码生成、角色扮演等领域的能力均有更新和提升。

示例为在网页端调用 DeepSeek-R1-0528 使用 HTML/CSS/JavaScript 开发的一个现代简约风格的单词卡片应用

API 更新

API 已同步更新,接口与调用方式保持不变。新版R1 API仍支持查看模型思考过程,同时还增加了Function Calling和JsonOutput的支持。

我们对新版 R1 API 中 max_tokens 参数的含义做了调整:现在 max_tokens用于限制模型单次输出的总长度(包括思考过程),默认为 32K,最大为 64K。请 API 用户及时调整 max_tokens 参数以防输出被提前截断。

本次R1更新后,官方网站、小程序、App端和API中的模型上下文长度仍为64K。如果用户对更长的上下文长度有需求,可以通过其他第三方平台调用上下文长度为128K的开源版本R1-0528模型。

模型开源

DeepSeek-R1-0528与之前的DeepSeek-R1使用同样的base模型,仅改进了后训练方法。私有化部署时只需要更新 checkpoint 和 tokenizer_config.json(tool calls 相关变动)。模型参数为 685B(其中 14B 为 MTP 层),开源版本上下文长度为 128K(网页端、App 和 API 提供 64K 上下文)。

(免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。 )