2月17日消息,近日,深信服一朵云面向AI进行全新升级,为用户打造更匹配大模型场景的智算承载、应用构建的AI平台,面向用户基于DeepSeek承载和应用的场景,提供一键部署、性能更优、快速开发应用的最佳实践方案。

总的来说,深信服一朵云面升级包含三个方面:

1、 线下基础设施从传统业务承载平台向智算承载平台升级,广泛适配包括DeepSeek在内的最新大模型。

深信服现已打造「HCI+AICP新一代超融合」解决方案,只需在原集群基础上增加一台GPU节点,就能基于本地集群快速部署并承载DeepSeek在内的企业级大模型。

除了支持英伟达GPU,深信服AICP算力平台和多家国产厂商开展了广泛的软硬件兼容测试,可适配天数智芯、昇腾、海光、沐曦、燧原等多款国产卡,为用户实现算力异构管理。

2、 线上托管云上线全新AI服务目录,提供DeepSeek等企业级大模型服务,用户可通过订阅来快速获取AI能力。

深信服托管云已支持基于专属资源+AICP的方式,为用户提供专属的企业级大模型服务,可满足用户对于线上部署专属服务模型的需求。

深信服会持续丰富线上服务目录,用户可以很容易地通过订阅的方式,快速平滑地获取AI能力,如DeepSeek等模型服务。

3、 全新发布AI应用创新平台,助力用户快速构建大模型应用,让AI应用的开发和运营变得更简单。

深信服AI应用创新平台内置RAG最佳实践流程,支持智能分片与直连企业自有知识库。用户仅需通过简单操作,即可构建高质量的RAG应用。深信服AI应用创新平台支持基于业务评测数据集的应用效果评估,并自动生成优化建议,用户无需理解复杂技术细节,即可完成配置优化,实现效果提升。

据介绍,向AI升级后,深信服全面优化推理性能,让跑在一朵云上的大模型应用可以实现推理性能的大幅提升,降低大模型整体使用成本。

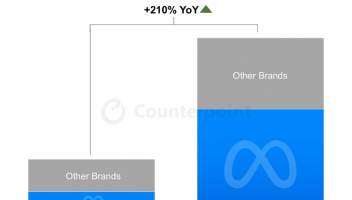

相比基于个人开发者常用的Ollama方案部署DeepSeek,深信服通过AICP算力平台的部署方案在多实例、并发推理场景中可实现5-10倍的性能提升。大模型并发度更高、吞吐量更大、推理响应延时更低,让用户在企业级AI应用构建及实际使用时,资源投入更低、体验更优。

4卡4090运行DeepSeek-32B模型,模拟64并发场景,做问答测试

以32B模型为例,日常问答场景(2k上下文),AICP并发是Ollama的8~10倍,总吞吐10倍以上。

硬件资源:INT4用2*4090,FP16用4*4090

知识库应用场景(4k上下文),AICP并发是Ollama的2倍,总吞吐4~8倍。

硬件资源:INT4用2*4090,FP16用4*4090

(免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。 )