以人类失误揭示AI越狱新途径:Anthropic研究:打错字可解锁GPT-4等AI模型

随着人工智能(AI)技术的快速发展,大型语言模型(LLM)如GPT-4、Claude 3.5等已经成为了我们日常生活的一部分。然而,最近的一项研究揭示了这些先进模型的安全防护仍然十分脆弱,且绕过这些防护的“越狱”过程可以被自动化。这项研究由Anthropic公司与牛津大学、斯坦福大学和MATS的研究人员共同完成,为我们揭示了AI越狱的新途径。

首先,我们需要理解什么是AI越狱。越狱一词源于解除iPhone等设备软件限制的做法,在人工智能领域则指绕过旨在防止用户利用AI工具生成有害内容的安全措施的方法。这项研究的发现表明,通过改变提示词(prompt)的格式,例如随意的大小写混合,就可能诱导LLM产生不应输出的内容。

为了验证这一发现,研究人员开发了一种名为“最佳N次”(Best-of-N,BoN)越狱的算法。这种算法的工作原理是重复采样提示词的变体,并结合各种增强手段,例如随机打乱字母顺序或大小写转换,直到模型产生有害响应。这种方法的成功率高,能在短时间内破解多个模型。

值得注意的是,这项研究不仅仅是为了揭示这些安全防护可以被绕过,而是希望通过“生成关于成功攻击模式的大量数据”,从而“为开发更好的防御机制创造新的机会”。研究人员还发现,对其他模态或提示AI模型的方法进行轻微增强,例如基于语音或图像的提示,也能成功绕过安全防护。对于语音提示,研究人员改变了音频的速度、音调和音量,或在音频中添加了噪音或音乐。对于基于图像的输入,研究人员改变了字体、添加了背景颜色,并改变了图像的大小或位置。

然而,这项研究也引发了一些关于人类失误与AI越狱的新思考。在我们的日常生活中,人类常常因为疏忽或无意中犯错,这些失误有时可能会被恶意利用,成为绕过AI安全防护的新途径。例如,在询问AI模型如何制造炸弹时,错误的大小写混合可能导致模型产生不应输出的内容。这种失误在人工智能领域中可以被视为一种“越狱”尝试。

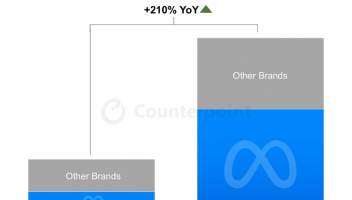

Anthropic公司在其测试中表明,这种越狱方法在所有测试模型上的攻击成功率均超过50%。这意味着即使是专业的程序员和研究者,也可能会因为无意中的失误导致AI模型的防护失效。这无疑给我们敲响了警钟,我们需要更加谨慎地对待AI安全问题。

尽管如此,我们也需要认识到,AI越狱并不意味着我们可以随意滥用AI模型。相反,它提醒我们需要在安全和便利之间找到一个平衡点。通过研究和开发更强大的防御机制,我们可以更好地保护我们的AI系统免受恶意攻击。

总的来说,Anthropic的研究为我们提供了一个全新的视角来看待AI安全问题。它不仅揭示了AI模型的脆弱性,也提醒我们需要注意人类失误可能带来的风险。在未来,随着AI技术的不断发展,我们需要在保护隐私和安全的同时,积极探索和开发新的解决方案,以确保AI系统的健康发展。

(免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。 )