极客网·人工智能(杭州)9月20日杭州云栖大会消息, NVIDIA DRIVE Orin系统级芯片实现了与阿里云通义千问多模态大模型Qwen2-VL的深度适配。阿里云、斑马智行联合NVIDIA英伟达推出舱驾融合大模型解决方案,基于通义大模型开发“能听会看”的智能座舱助理,让车内人员通过语音交流就能操作座舱内的各类应用,享受极致丰富的交互体验。

AI大模型正在引领新一轮产业变革,汽车行业是最受关注的大模型应用领域之一。作为“大模型上车”的重要切入点,汽车座舱的智能进化广受期待。大模型接入智能座舱,有望为乘客提供座舱环境控制、车内休闲娱乐、驾驶行为监测等拟人化的服务。

通义大模型的智能座舱解决方案,能为座舱配备一位具备感知、思考、决策能力的“智能助理”,它不仅能观察理解用户的语音、手势,还能根据环境信息和常识判断做出自主决策。乘客无需物理按键,只要动动嘴巴,就能让智能助理完成各种任务。

这个解决方案以通义大模型为“大脑”,集成了通义大语言模型Qwen2-7B和通义多模态模型Qwen2-VL。Qwen2-VL是阿里通义实验室研发的新一代视觉语言模型,具备业界最强的图片识别能力和视觉智能体能力,在多个国际权威测评中创下同等尺寸最优成绩。Qwen2-VL的2B和7B参数模型因其性能和尺寸的“极致性价比”,尤其适合汽车等端侧场景。同时,通义实验室最新发布的 Mobile Agent V3 首次落地汽车座舱场景,提供座舱屏幕感知、复杂任务规划以及座舱应用 UI的操作决策能力,大大扩展座舱智能助理的能力边界。

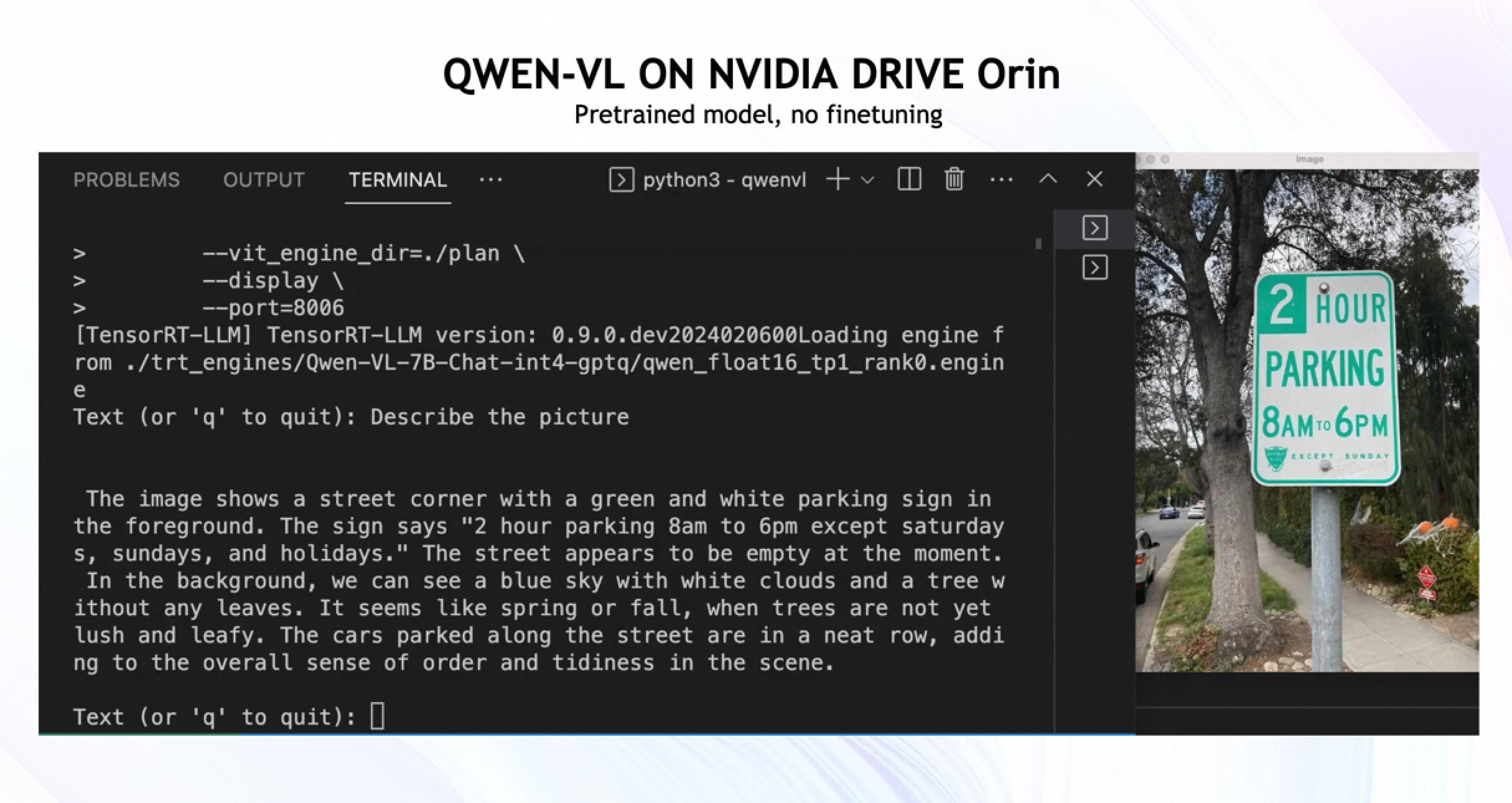

跑在NVIDIA DRIVE Orin芯片上的Qwen-VL,可以自动识别右侧画面信息,并回答用户的提问,如“我可以在这停车吗?”

本次解决方案基于端云一体架构,端侧通义大模型经NVIDIA 英伟达自动驾驶和座舱芯片NVIDIA DRIVE Orin加速。NVIDIA英伟达提供了强大的芯片适配技术支持,通过优化GPU 架构和驱动软件,确保充分发挥大模型的性能潜力。NVIDIA的模型加速技术有效降低了大模型在实时处理复杂任务时的计算成本和时间延迟,为用户创造了流畅无阻的智能体验。未来,通义大模型还将采用 NVIDIA DRIVE Thor新一代集中式车载计算平台。

阿里旗下的智能出行解决方案提供商斑马智行,为舱驾融合多模态大模型解决方案的落地提供了工程环境,将大模型能力丝滑嵌入汽车座舱、匹配用户操作习惯。

(免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。 )