3月31日消息,在2025中关村论坛年会人工智能主题日上,零一万物 CEO、创新工场董事长李开复发表演讲,其中提到对DeepSeek的四点观察:

第一个观察是,DeepSeek破解并开源推理模型的思考训练过程,进一步缩小与美国的差距。

第二个观察是,DeepSeek 极其高效的工程效率,这走出了一条与OpenAI天量级融资的底层逻辑迥然不同的中国道路。

第三个观察,也是最重要的一点,DeepSeek 证明了开源模型能力追赶上闭源模型,进一步推进SOTA模型的商品化。

第四个观察,中国迎来了属于自己的“DeepSeek Moment”,将大幅加速大模型在中国的全面落地。

以下为李开复演讲全文记录:

非常高兴又有机会来中关村论坛分享我对过去这几个月 AI 领域所发生的一些重大事件的观察,以及我眼中的 AI 行业蓝图。

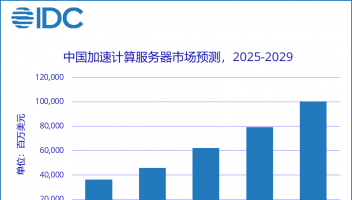

AI 2.0 是有史以来最伟大的科技革命与平台革命,大模型走出实验室,穿透各行各业成为驱动实体经济的新质生产力。在过去两年间,从 ChatGPT 推出之后,大模型智力在不断地提升,而且目前看起来远没有触及天花板。与此同时,大模型的推理成本在以每年降低十倍的速度快速下降,这为AI-First应用爆发提供了非常重要的条件。两年前模型性能不够好的模型,现在已经够好了;两年前推理成本太贵的模型,现在已经是“白菜价”了。所以在我看来, AI-First 应用很快将井喷,2025 年将会是 AI-First 应用爆发、大模型“落地为王”的元年。

几个月前,前 OpenAI 联合创始人 Ilya 公开表示,预训练阶段的 Scaling Law 已经放缓。因为模型训练所用的数据量已经触及瓶颈,算力方面也存在着客观制约因素——超大 GPU 集群效益降低,随着 GPU 数量增加容错问题等导致边际效益降低。即便训练出超大参数量的大模型,比如 OpenAI 所发布的 GPT-4.5,模型性能确实有提升,但是 GPT-4.5 的价格是 DeepSeek-V3 的 500 倍。在绝大多数生产力场景里,超大参数量的模型价格昂贵速度缓慢,性价比并不突出。

好在行业内已经出现了新的曙光,Scaling Law 正从预训练阶段转向推理阶段,也就是慢思考模式。过往预训练阶段的 Scaling Law 是指:有更多的 GPU、更多的数据,模型就可以变得更聪明,但目前看其增长趋势放缓了。新的慢思考 Scaling Law 是指:模型思考的时间更长,就会得出有更优质的结果。目前看来,慢思考 Scaling Law 下,模型性能的成长速度非常快,而且还有很大的增长空间。

结合这些新的技术创新,现在模型训练的过程变得非常有意思。先训练一个“文科生”,让模型阅读所有的书籍,然后再向理科方向训练,让模型能够证明数学题、会写代码,最终得到的“文理双全”的模型会非常厉害。

另外一个值得关注的点在于,模型性能的提升其实在加速,而不是在放缓。从 GPT-2 到 GPT-3、从 GPT-3 到 GPT-4.5,每一次升级都花了大约两年的时间,为什么呢?本质上还是人在训练模型,是人来规划新的算法、新的模型架构、再搭配更多 GPU、再投入更多数据,最终推动模型性能的提升。

但今天,我们进入了一个非常有意思的“AI 教 AI”的时代。从 OpenAI 发布 o1 到 发布 o3,中间只隔了三个月。 DeepSeek-R1 也是在 OpenAI o1 发布的两个月之后就正式发布,并且可能很快就会发布 R2。无论是从 o1 到 o3,还是从 R1 到 R2,模型迭代的速度缩短到了三个月。一个重要的原因就是现在很大程度上已经不再单单依靠人来发明新算法、发明模型架构,而是 AI 借由慢思考具备了反思的能力,能够自我迭代、自我进步,也就是“AI 教 AI”,AI进入到自我演进范式。

经过慢思考,AI 正变得越来越聪明。模型性能更好的模型可以去教那些基础较弱的模型,超大参数模型可以去训练参数量较小的模型。这样的搭配类似“老师”和“学生”,经过蒸馏、数据标注和合成数据,未来模型性能的提升会进一步加速。超大预训练模型的价值将进一步体现在“教师模型”的角色中,其本质也将更趋进于大模型时代的基础设施。

最近,社会各界都在讨论 DeepSeek,我也来分享一下我对 DeepSeek 的四个观察。

第一个观察是,DeepSeek破解并开源推理模型的思考训练过程,进一步缩小与美国的差距。

DeepSeek 很快让模型具备了 Reasoning (推理)慢思考的能力。DeepSeek-R1 真正切实掌握了这一技术,并且还公开了 DeepSeek-R1 的思维链。这是非常令人震惊的,因为 OpenAI o1 一直隐藏着思维链,就是防止友商复现,结果 DeepSeek 还是从零起步做到了这一点。

第二个观察是,DeepSeek 极其高效的工程效率,这走出了一条与OpenAI天量级融资的底层逻辑迥然不同的中国道路。在同样标准下进行比较,DeepSeek-R1 要比美国的类似模型更快,也更便宜了 5 到 10 倍,这背后是工程能力的巨大进步。

第三个观察,也是我认为最重要的一点,DeepSeek 证明了开源模型能力追赶上闭源模型,进一步推进SOTA模型的商品化。DeepSeek 证明了闭源的路径是不可取的,开源才能有更好的发展。如果 DeepSeek 没有开源,我大胆揣测,它的影响力会远远不如今天。在美国的开源社区和社交媒体,大部分人都在热情拥抱 DeepSeek,过往很少有中国软件在海外收获如此广泛的欢迎。这很大程度上就来自于,与闭源的 OpenAI 相比,DeepSeek 更为开放。

第四个观察,中国迎来了属于自己的“DeepSeek Moment”,将大幅加速大模型在中国的全面落地。大概 9 个月前,我曾经沮丧地说,中国还没有“ChatGPT moment”,虽然过去也有表现不错的模型出现,但是却始终缺少一个一枝独秀的模型,能够支撑 ToB、ToC 应用百花齐放,能够让每个企业 CEO 都在追问 IT 部门“什么时候能在企业里接入大模型?”现在企业和用户已经经过“DeepSeek Moment”的市场教育,中国市场真正觉醒了,这也为 中国AI-First 应用的爆发扫清了一大障碍。

因为过去做大模型应用最大的瓶颈之一,就是需要教育市场。如果一个初创公司需要教育市场,那它几乎没有成功的可能,因为教育市场需要的时间太长,前景未卜。今天 DeepSeek 完成了对中国 ToB、ToC市场的市场教育, AI-First 应用爆发又多了一个强有力的支撑。

DeepSeek 的基座模型很优秀,但是如果要落地企业生产力场景,还有一些卡点需要克服。很多企业 CEO 希望能够本地部署、安全部署,因为部分 CEO 处于数据安全的考虑不希望公司数据上网,所以不能直接用 API。在应用实践方面,很多公司需要有更好的联网搜索、Deep Research(深度研究) 等功能,也需要用 RAG技术(检索增强生成,Retrieval-augmented Generation) 链接企业数据库,如ERP、CRM等系统。此外还有企业希望能够在基座模型基础上开发应用、打造企业专属智能体。最后还有很多企业需要基于 DeepSeek 模型进行模型微调,甚至需要继续预训练,从而让DeepSeek 等基座模型持续进化,最终成为能在企业专属的“行业大脑”。

基于上述考量,零一万物在过去几个月也做出了战略调整,我们已经全面拥抱 DeepSeek,并且把大部分力量用于把 DeepSeek 优质基座模型转变为企业级企业级 DeepSeek 部署定制解决方案——可以类比为零一万物在打造AI 2.0时代的Windows系统,而DeepSeek就是驱动Windows的内核。区别于普通软件公司或系统集成商提供的浅层方案,零一万物2年来在安全部署、应用实践、行业定制已经具备成熟且全链条的技术栈能力——只有真正做过顶尖大模型训练、模型微调到应用的大模型公司才能够提供专业成熟的、一站式的深度服务。

最后我想说的这点大家此前或许没有过多关注。随着全世界开始拥抱 ChatGPT、DeepSeek,一个很大的问题开始浮现。对于小语种而言,很多基座模型的表现并不好。以俄语为例,在 Llama 的训练语料中俄语占比仅 0.13%,因此 Llama 在俄语上的表现并不好,在东南亚、中东、中亚、非洲等国家和地区的小语种表现上更是表现不佳。我一个朋友是斯坦福语言学教授,他认为目前大模型基本忽视了 7000 多个小语种,可能会加速这些语言的灭绝。康奈尔大学的研究也显示,每个国家和地区之间的价值观是存在不小的偏差。所以让每个国家和地区都有机会训练自己语言的模型、训练出符合自身价值观的模型,不仅必要而且是这些国家和地区的刚需。

我们很幸运的是,中国很多大模型公司在训练中文大模型,但是很多小语种的国家并没有。这也是零一万物推出小语种模型的初衷,零一万基于每个国家可优化出不同的模型对齐策略,我们也积极响应“一带一路”倡议实现共赢发展,期待与“一带一路”国家携手合作,让更多国家能够拥有自主可控的大模型。

今年开源模型的胜利是一件大事,“DeepSeek Moment”的出现也是一件大事。今年可以预见的是, AI-First 应用将会迎来爆发。AI需要市场,市场也需要AI。各家模型公司也必须要回归商业本质,想清楚公司如何利用技术真正为客户创造价值。零一万物认为,今年的一个焦点问题应该是:Make AI Work,让大模型真正赋能千行百业,谢谢大家。

(免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。 )