财联社4月20日讯(编辑 史正丞)在过去半年不到的时间里,许多地球上的人类已经接触到AI聊天机器人的魅力和魔力。但归根结底,目前并没有AI已经产生像人类一样的自我意识,它们能够模仿人类讲话,主要原因是算法“吸收”了大量的文本——大部分是从互联网上抓取的。

互联网上蕴含着大量有用、有益的经验和知识,但数字时代的网民们也不得不承认,在烟波浩渺的互联网信息丛林中,也蕴含着大量偏见、歧视、有害,以及侵犯名誉和隐私的内容。种种迹象显示,这些“人类的禁忌知识”也被大模型照单全收了。

当地时间周三,《华盛顿邮报》发表了与艾伦人工智能研究院合作进行的调查结果,他们拆解了谷歌的C4数据集,这也是许多知名英语AI大模型的训练材料,例如谷歌的T5和Facebook的LLaMA。中国投资者更关注的OpenAI并没有公布训练ChatGPT所用的数据集,所以这也是目前窥得AI数据黑箱的最便利解决方案。

AI数据集黑箱揭秘

值得一提的是,调查人员使用了SimilarWeb的网站分类数据,由于C4数据集中有三分之一的网站已经不存在这个世界上了,所以实际统计的数据大约为1000万个网站。

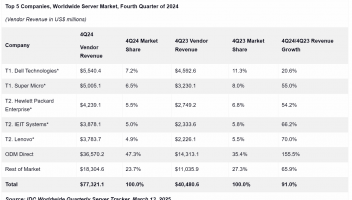

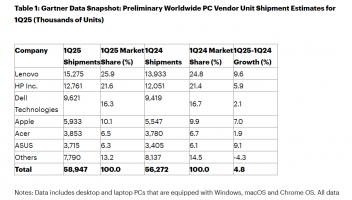

根据研究,囊括全球专利信息的谷歌专利网、维基百科和订阅制数字图书馆scribd的资料权重位列整个数据集前三。但随着列表往下翻,一系列意想不到的名字开始出现。

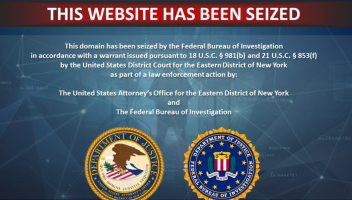

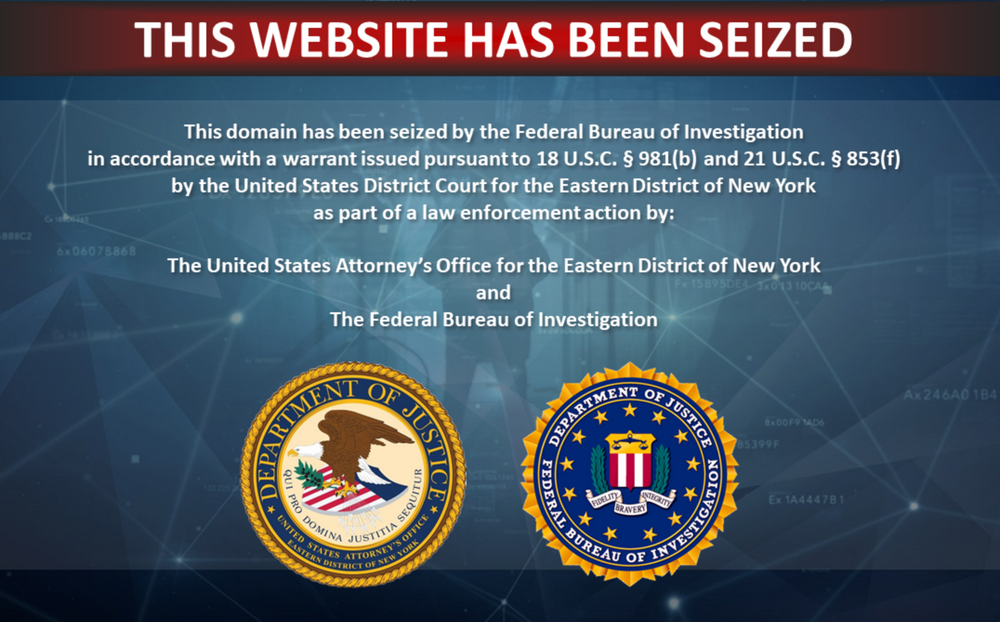

已经被美国司法部查封的盗版电子书网站b-ok.org高居第190位,类似这样因为侵犯版权被美国查封的网站还在数据集中出现至少27次。

(b-ok.org现在是这个样子的,来源:网站)

此外,《魔兽世界》玩家论坛wowhead也高居第181位,《赫芬顿邮报》创始人阿里安娜·赫芬顿办的行为转变课程网站thriveglobal也位居175位。令人意外的是,有两个美国投票人数据库网站也位列前100位。虽然投票人的数据本身是公开的,但大模型可能会把这些个人数据用在哪里,又有谁能说清楚呢?

接下来的数据则显示,AI大模型潜在的侵权问题,可能要比想象中更加严重。商业和行业网站是数据集中比重最大的分类,创意产品众筹网站kickstarter(25位)也出现在榜单里非常高的位置。这里就引出了一个新的问题,AI向用户提供的许多创意和市场营销答案,很有可能本身就是现成的作品。

研究人员也发现,超过50万的个人博客被收录进C4训练集中,这些作者显然没有因此得到过任何报酬。

作为AI训练的“富矿”,每天都大量生产经过审校内容的媒体也是训练集的最爱,纽约时报、洛杉矶时报、卫报、福布斯和赫芬顿邮报均挤进数据库比重前十。与许多艺术家一样,不少媒体目前也在向AI产业声索维权。由于美国媒体行业的复杂性,所以训练集中也能找到以极右翼、白人至上主义内容为主基调的网站。

事实上,谷歌在构建数据库的时候,已经意识到网络信息污染的问题,所以除了删除毫无意义和重复的语句外,特意用开源的“脏话过滤器”筛过一遍,但似乎有数量非常庞大的漏网之鱼钻了过去。研究人员就在训练集中找到至少7.2万个德国纳粹的标志性符号。

更令人担忧的是,训练集中也能找到宣扬种族主义、极右翼阴谋论(QAnon)的网页,而以组织网络暴力闻名的4Chan匿名聊天网站也出现在训练集中。

比起数据脏 处理数据的态度更迷离

虽然C4训练集的数据已经非常庞大,但用于训练OpenAI GPT-3的网络爬虫数据集,从一开始就要比C4大40倍,背后的问题自然也会被同步放大。

但在GPT-3的论文中,OpenAI也公开讨论了一个细节:在防止测试数据被放进训练数据导致污染的过程中发现了一个BUG,但由于重新训练模型太贵、公司又没钱,所这个问题就放着不去管它了。

一些业内人士也透露,许多科技公司在内部都不会记录训练数据的来源,因为担心会发现个人信息数据,以及未经授权的材料或其他数据。

(免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。 )