拥抱未来:Hugging Face最小AI视觉语言模型震撼登场,内存低于1GB PC也能驾驭,开启AI新纪元

随着科技的飞速发展,人工智能(AI)已经逐渐渗透到我们生活的各个角落。在这个充满无限可能的领域,Hugging Face平台再次引领潮流,推出两款全新的轻量级AI模型——SmolVLM-256M-Instruct和SmolVLM-500M-Instruct,这两款模型以其小巧的身形和卓越的性能,为AI领域带来了一场革命。

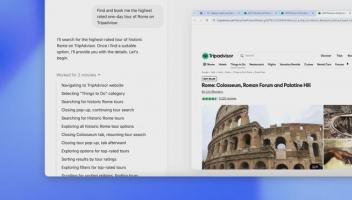

Hugging Face是一家专注于提供一站式AI平台的公司,其平台旨在为开发者提供便捷、高效、灵活的AI工具和服务。此次发布的SmolVLM-256M-Instruct模型,仅有2.56亿参数,是有史以来发布的最小视觉语言模型。这款模型在内存低于1GB的PC上运行,提供了卓越的性能输出。不仅如此,其先进的多模态能力使其能够执行图像描述、短视频分析以及回答关于PDF或科学图表的问题等任务。

而对于硬件资源有限,又需要处理大规模数据分析的开发者来说,SmolVLM-500M-Instruct模型无疑是他们的福音。这款模型仅有5亿参数,主要针对硬件资源限制,帮助开发者迎接大规模数据分析挑战,实现AI处理效率和可访问性的突破。

这两款模型的发布,标志着Hugging Face在AI领域的研究又迈出了坚实的一步。其采用更小的视觉编码器SigLIP base patch-16/512,通过优化图像标记的处理方式,减少了冗余并提高了模型处理复杂数据的能力。这不仅降低了模型的大小和运行成本,也提高了其在内存低于1GB PC上的性能。

值得一提的是,这两款模型的开发依赖于两个专有数据集:The Cauldron和Docmatix。The Cauldron是一个包含50个高质量图像和文本数据集的精选集合,侧重于多模态学习,而Docmatix则专为文档理解而定制,将扫描文件与详细的标题配对以增强理解。这两个数据集的高质量和针对性,为模型的训练提供了有力的支持。

此外,SmolVLM模型能够以每个标记4096像素的速率对图像进行编码,这比早期版本中每标记1820像素有了显著改进。这种改进不仅提高了模型的性能,也降低了对硬件资源的需求,使得SmolVLM模型在内存低于1GB的PC上也能发挥出色的性能。

总的来说,Hugging Face推出的这两款最小AI视觉语言模型,以其小巧的身形、卓越的性能和先进的多模态能力,展示了AI技术的无限可能性和广阔的应用前景。它们不仅为硬件资源有限的设备提供了强大的AI支持,也为开发者们提供了应对大规模数据分析挑战的新工具。这无疑将开启AI的新纪元,为我们的生活带来更多的便利和智慧。

面对这一历史性的时刻,我们应以开放和接纳的心态去拥抱这个充满无限可能的未来。让我们期待SmolVLM系列模型在未来的应用中,为我们的生活带来更多的惊喜和改变。在拥抱未来的同时,让我们也记住那些为科技进步默默奉献的科学家和工程师们,他们的努力和智慧是推动科技进步的动力源泉。

(免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。 )