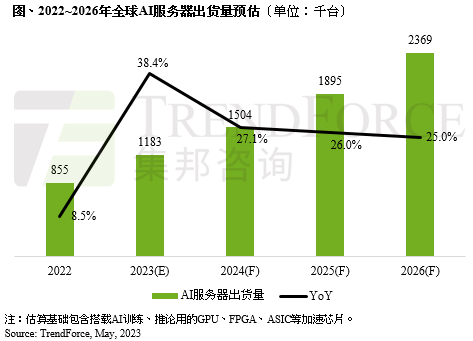

5月30日消息(颜翊)TrendForce集邦咨询发布报告称AI服务器及AI芯片需求同步看涨,预估2023年AI服务器(包含搭载GPU、FPGA、ASIC等)出货量近120万台,同比增长38.4%,占整体服务器出货量近9%,至2026年将占15%。2022~2026年AI服务器出货量年复合增长率同步上调至22%,AI芯片2023年出货量将增长46%。

TrendForce集邦咨询表示,NVIDIA GPU为AI服务器市场搭载主流,市占率约60~70%,其次为云端业者自主研发的ASIC芯片,市占率逾20%。NVIDIA市占率高的主要原因有三,其一,目前不论美系或中系云端服务从业者(CSP),除了采购原有的NVIDIA的A100与A800外,下半年需求还将陆续导入H100与H800。

其二,高端GPU A100及H100的高获利模式也是关键,由于NVIDIA旗下产品在AI服务器市场已拥有主导权的优势,据TrendForce集邦咨询研究,H100本身的价差也依据买方采购规模,会产生近5000美元的差异。

其三,下半年ChatBOT及AI运算风潮将持续渗透至各种专业领域(如云端/电商服务、智能制造、金融保险、智慧医疗及智能驾驶辅助等)的开发市场,同步带动每台搭配4~8张GPU的云端AI服务器,以及每台搭载2~4张GPU的边缘AI服务器应用需求渐增,预估今年搭载A100及H100的AI服务器出货量年增率逾5成。

此外,从高端GPU搭载的高带宽内存(HBM)来看,NVIDIA高端GPU H100、A100主采HBM2e、HBM3。以今年H100 GPU来说,搭载HBM3技术规格,其中传输速度也较HBM2e快,可提升整体AI服务器系统运算效能。随着高端GPU如NVIDIA的A100、H100;AMD的MI200、MI300,以及Google自研的TPU等需求皆逐步提升,TrendForce集邦咨询预估2023年HBM需求量将年增58%,2024年有望再成长约30%。

- 四部门联合发布《人工智能生成合成内容标识办法》9月1日起施行

- OpenAI游说白宫:既要放宽AI监管,又要打压DeepSeek

- AI革命再升级:比尔盖茨预言AI助手将人手一个,优先处理最重要的事

- Salesforce CEO 直言微软Copilot翻车:伪装ChatGPT忽悠客户,令人深感不满!

- 消息称微软许可即将到期,华为笔记本将告别Windows,全部改用鸿蒙

- 北京中小学首度揭秘:AI应用场景将引领教育革新

- 谷歌截胡 OpenAI,全模态模型 Gemini 2.0 引动漫游戏圈关注,中文唠嗑式 P 图掀起新热潮

- 库帕思携手智元机器人,共绘具身智能产业新篇章:打破边界,加速未来发展

- 潞晨科技开源视频生成模型Open-Sora 2.0惊艳登场:性能超越OpenAI Sora,开源风暴即将来临

- 西班牙通过新法案 未标注AI生成内容的企业将面临重罚

免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。