12月20日消息(南山)在日前举办的英伟达 GTC China 2019大会上,“教主”黄仁勋发布了一系列新品,其中TensorRT 的最新版本TensorRT 7令人瞩目,相比去年发布的TensorRT 5,TensorRT 7 可支持各种类型的 RNN、transformer、CNN,能够融合水平与垂直方向的运算,支持 1000 多种不同的计算变换和优化。黄仁勋举例,有了 TensorRT 7 的支持,在 GPU 上编译会话模型只需要0.3秒。

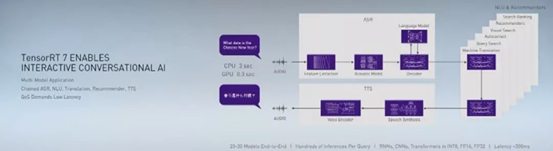

TensorRT 7的典型应用,是支持交互式会话AI,为实现更加智能的AI人机交互打开了新大门。在大会期间,英伟达加速计算产品管理总监Paresh Kharya等人接受C114/机器成精等媒体采访,对TensorRT 7新平台、兼容ARM等热门话题进行了解读。

支撑会话式AI全流程

Paresh Kharya介绍,AI技术正在取得长足进展,最新的应用包括会话式AI和推荐系统。其中,会话式AI是一个非常复杂的任务,需要AI理解语音、文本、语言,整个过程分为三个部分:识别你所说的,将你所说的话转化为文字,理解这些文字并转化成语言再说出来。随着英伟达不断发布新版本,TensorRT 7可以完成三个流程计算,从语音识别到语义理解再到语音输出。

“要想把会话式AI做得有用,需要符合两个条件,要在300毫秒内将整个三部分完成,而且要完成的非常智能。在这个过程当中,有非常多的复杂模型需要计算,Tensor RT也在不断完善。” Paresh Kharya表示。

“推荐系统也是至关重要的一环,甚至已成为了互联网最重要的引擎。” Paresh Kharya强调,用户面临的选择越来越多,网络的信息量呈现爆炸式增长,包括商品、视频,以及各类选择的参数的数量都在爆炸式增长。“商品达到数十亿级别,网络视频百万量级增长,新闻每天都在产生海量数据。阿里巴巴、百度,都使用了英伟达的平台支持他们的推荐系统。”

这些信息在实时、动态的变化过程中,只有不断对模型进行训练,才可以有效地推荐。训练模型需要大量算力,英伟达提供了不断更新的各类工具和软件,比如最新的软件Tensor RT 7,支持各类模型在各种情景下的部署,支持上百万的用户在每秒内做数十亿次的搜索。

例如,阿里的边缘系统如果在英伟达的GPU上跑,每秒可以做780次查询;但是如果用CPU,每秒只能做3次查询。

与ARM合作,给客户更多选择

本次大会上,英伟达还宣布ARM处理器可以使用其GPU加速技术、NVIDIA Magnum IO套件,以及在Microsoft Azure上使用的新型云加速GPU超级计算机等。换句话说,英伟达将全方位扩展高性能计算领域。

Paresh Kharya指出,ARM是被业界广泛使用的架构,服务全球1500亿台设备。其成功的一个重要原因是开放平台,各家公司都能够在ARM架构上进行创新,ARM也能够提供互联、内存、CPU内核、计算能力等各种功能。英伟达将通过CUDA平台和ARM架构进行兼容,在高性能计算领域,给客户更多选择。

“加速计算和过去以CPU为基础的计算很不一样,性能提升是20、30甚至是100倍的。原因不仅是在架构上进行了设计,更重要的是通过软件优化和支撑。比如我们有各种各样的平台,像应用在医疗领域的Clara平台,应用在自动驾驶领域的Drive以及Isaac,做到了硬件和软件的结合。” Paresh Kharya表示。

当前,对于GPU,业界既用于图像处理,也有一些特别的客户会剥离图像处理能力,专注于加速技术应用。Paresh Kharya认为,英伟达丰富的产品线,能够满足客户的差异化需求,例如应用于数据中心的GPU就没有图像处理部分,通过Tensor Core做AI加速计算。一些新品如RTX6000、RTX8000,则图像处理和AI加速功能兼具。“我们的优势是统一的架构应用于各种工作负载当中实现加速计算,这意味着在各个行业中、各种各样的商业机会。”

业界人士云集GTC China 2019

免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。