极客网·极客观察(朱飞)12月3日 美东时间12月1日,国际权威AI基准测试MLPerf™公布了最新一期的训练(Training)榜单V1.1。结果显示,在全部16个固定任务(Closed)测试中,英伟达和浪潮信息包揽了15个冠军,形成了罕见的霸榜现象。

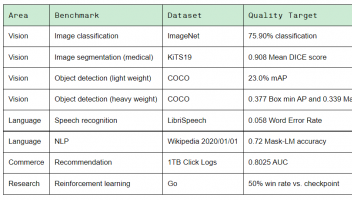

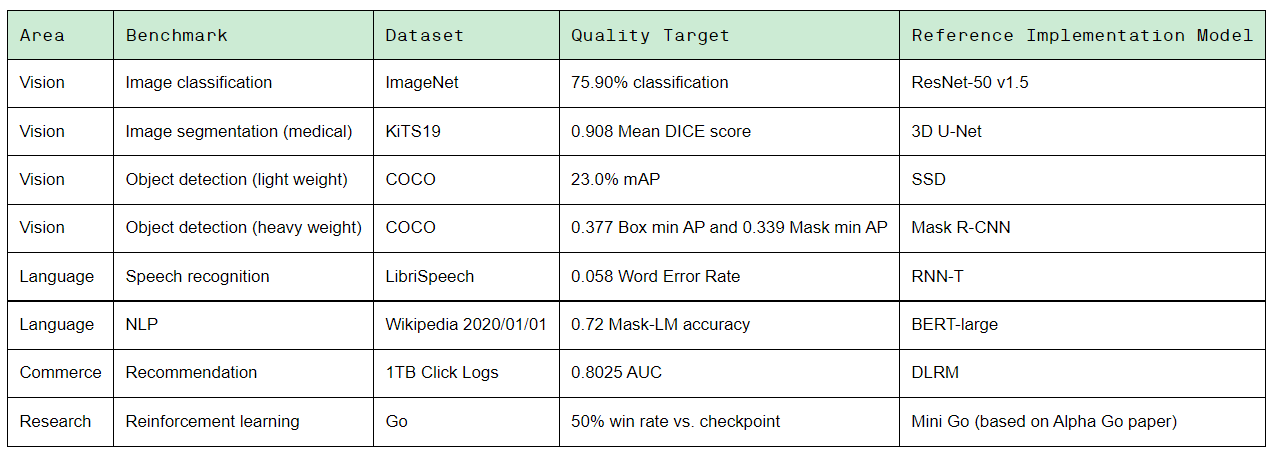

MLPerf™ AI训练测试分为集群测试与单机测试两个场景,各自涵盖图像识别(ResNet)、医学影像分割(U-Net 3D)、目标物体检测(SSD)、目标物体检测(Mask R-CNN)、语音识别(RNN-T)、自然语言理解(BERT)、智能推荐(DLRM)和强化学习(MiniGo)8类极具代表性的机器学习任务,旨在考察各家产品完成AI任务训练的时间,时间越快代表性能越强。

作为AI“跑分”领域的“奥林匹克”,MLPerf™打榜一向最为牵动AI产业各界的神经。特别是其中的固定任务(Closed)测试,因要求参赛各方使用相同模型(或与参考模型等价的模型)和限定的优化器,对实际用户评判AI计算系统性能具备很强的参考意义,一直以来便是厂商角逐最激烈、用户选型最关注的领域。

本轮MLPerf™ AI训练测试结果有何看点?“跑分”竞速背后蕴藏着AI产业怎样的发展趋势?这些结果和趋势对数智化浪潮下的千行百业企业意味着什么?让我们一探究竟。

从V1.0到V1.1,MLPerf™霸榜现象愈发显著

和云计算类似,AI基本上被认为最终会是少数几家“大厂”的竞技场。背后的支撑逻辑在于:AI作为新一代通用目的技术,其能力进化十分仰赖计算系统的独到设计、全栈技术的迭代创新、应用(数据)的规模反哺等,具备综合能力的大厂更容易“越滚越大”。

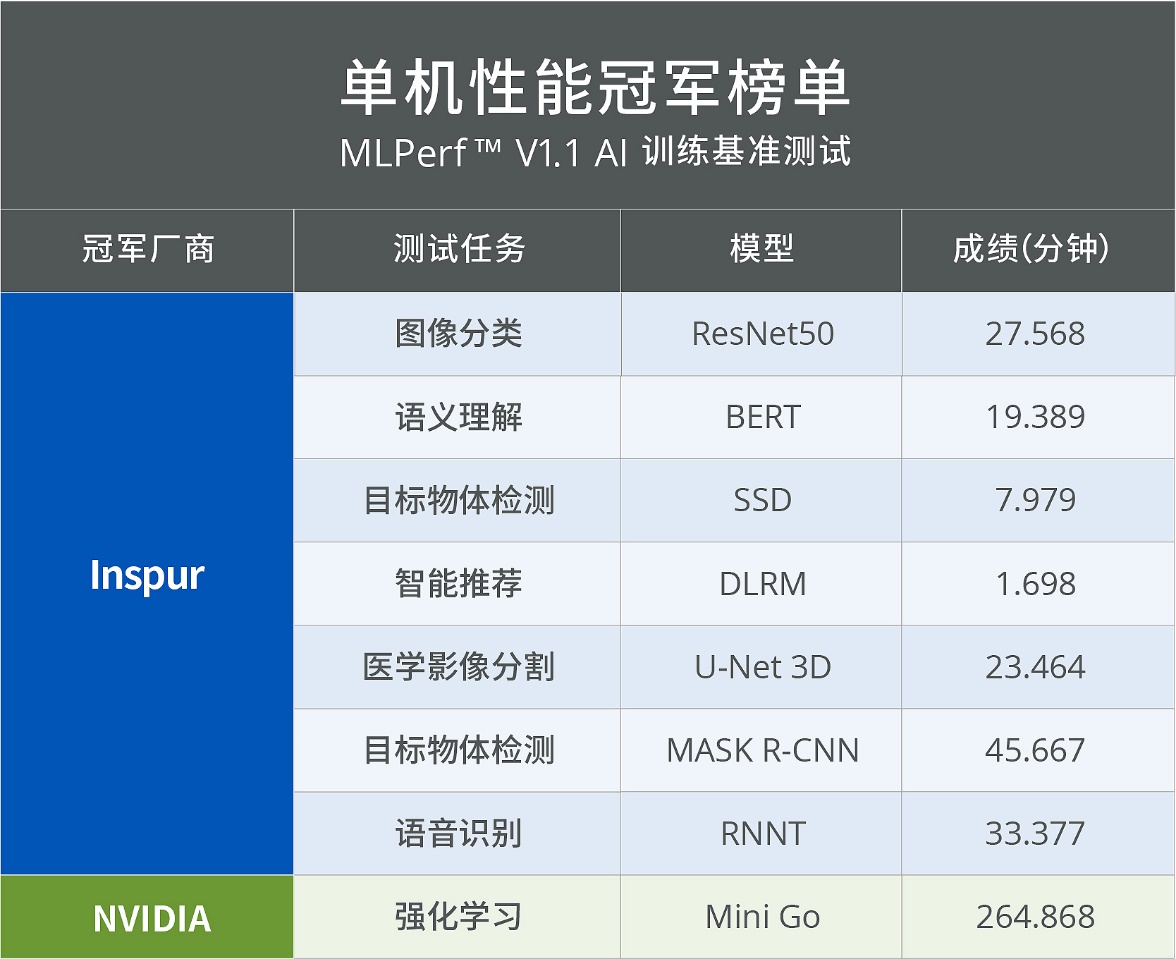

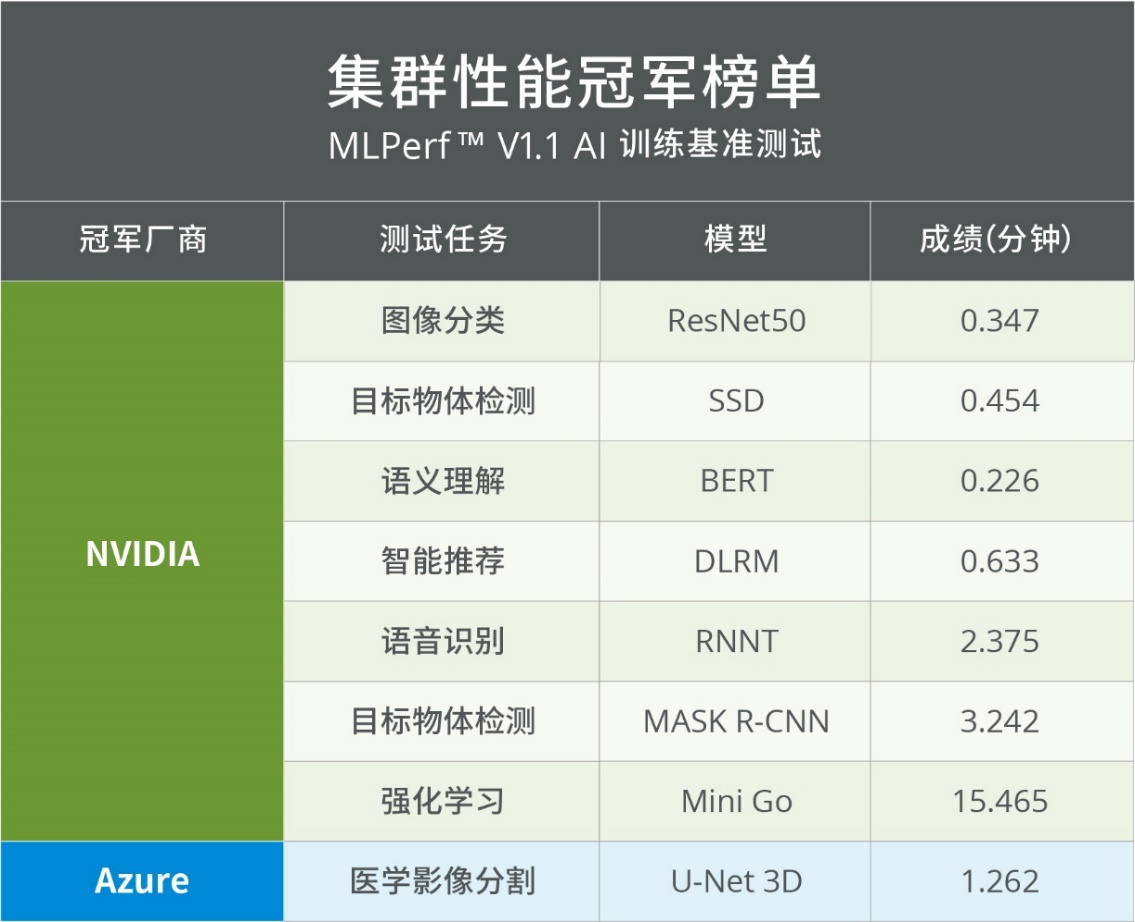

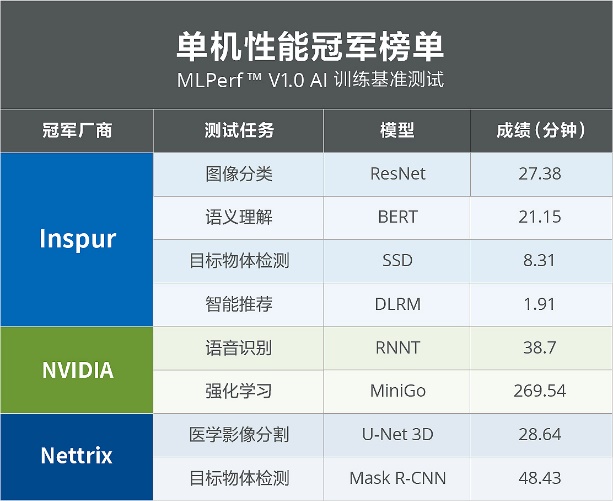

谷歌、微软云、英伟达、浪潮信息、百度、戴尔等14家公司及科研机构参与了此次MLPerf™ AI训练测试,共提交了180项固定任务(Closed)成绩和6项开放任务(Open)成绩。在单机测试的8项固定任务中,浪潮信息获得7项冠军,英伟达获得1项冠军;在集群测试的8项固定任务中,英伟达获得7项冠军,微软云获得1项冠军。

在半年前的V1.0中,英伟达和浪潮信息还分别“只”拿下16项固定任务(Closed)中的6项和4项冠军,半年后两家即以8项和7项冠军霸榜V1.1,足见AI领域的马太效应正在加速发生。

同样的现象也发生在MLPerf™ AI推理测试中(MLPerf™每年组织AI推理及AI训练性能测试各2次)。数据显示,在2021年MLPerf™数据中心推理和边缘推理两大场景的固定任务(Closed)测试中,浪潮信息与英伟达分别拿下全部63个任务中的33项和14项冠军,同样排在榜单前两位。

总体来看,随着MLPerf™ 2021年度4次测试全部收官,全球高手同场竞技,头部效应愈发明显。其中,浪潮信息共斩获44项冠军,名列MLPerfTM2021年度冠军榜首;英伟达共拿下28项冠军,位居第二;戴尔(11)、高通(5)、谷歌(4)分列第三、第四、第五位。

AI行业不“内卷”,AI计算系统性能仍在跃升

值得注意的是,MLPerf™打榜中头部玩家越来越强,并非业界AI计算系统性能提升停滞,或者“友商不给力”。相反,从V1.0到V1.1,既不乏“新鲜血液”加入竞争,也能明显看到AI性能仍在持续提升。这表明,AI行业不“内卷”,全球顶级玩家之间的竞争还很激烈。

资料显示,虽然训练评测V1.1相比V1.0在参与厂商数量上只增加了1家(微软云、百度、HPE、三星加入,英特尔、Nettrix、PCL & PKU缺席),但MLPerf™打榜热度丝毫不减,直观体现在最主要的固定任务(Closed)赛道劲增了55个任务成绩,使得各家提交的任务成绩总量达到创新高的180个。

与此同时,各项冠军的表现也越来越优异。在单机系统测试的8项任务中,相较半年前的V1.0竞赛最佳成绩,浪潮信息将医学影像分割、语音识别、智能推荐和自然语言理解任务的AI训练速度分别提升18%、14%、11%和8%。英伟达在单机系统测试中获得强化学习1项冠军,训练速度相较V1.0提升2%。

|  |

单机性能冠军V1.0 vs. V1.1

在集群系统测试的8项任务中,相较于V1.0竞赛最佳成绩,英伟达将自然语言理解、目标物体检测(MASK R-CNN)、语音识别任务的AI训练速度分别提升22%、18%、14%。微软云在集群系统测试中夺得1项冠军,以1.26分钟完成医学影像分割任务训练,训练速度相较V1.0提升58%。

|  |

集群性能冠军V1.0 vs. V1.1

这其中令人印象深刻的是,在MLPerf V1.0至V1.1推理比赛中,浪潮信息是唯一率先实现支持8颗A100-SXM-80GB(500W) GPU服务器的厂商,其他厂商能够支持的同款GPU数量只有4颗;而在V1.1训练测试中,Supermicro也第二家推出了单机搭载8块A100-SXM-80GB(500W) GPU的机型SYS-420GP-TNAR,在主要配置上与浪潮信息的NF5688M6实现了看齐,标志着单机AI服务器正加速迈进“八卡A100 500W时代”。

从实际表现看,尽管距离榜首浪潮信息仍有一定的差距,但Supermicro这款产品在图像识别(ResNet)、医学影像分割(U-Net 3D)、目标物体检测(SSD)任务上都取得了TOP3的优异成绩,足见AI业界在推动主流机器学习任务性能提升方面还在你追我赶、不懈努力。

谈及AI服务器在MLPerf™基准评测中的出色表现,浪潮信息方面表示主要是得益于公司在AI计算系统创新上卓越的系统设计能力和全栈优化能力,涵盖硬件的精细校准和全面优化、软件的调优,以及散热技术创新等。而这些能力是建立在浪潮信息对客户应用场景理解之上的,包括在产品研发、客户需求、实际应用中所获得的洞察和理解。

英伟达方面也表示,其在MLPerf™基准评测中的突破性性能得益于硬件、软件和系统层面技术的紧密结合,公司在全栈性能上的持续投资使得其吞吐量相较之前的MLPerf™ 测试提交成绩有所提高。

固定任务与开放任务“冷热”不同,AI加速落地

本次MLPerf™训练榜单结果还有一个显而易见的趋势,那便是与固定任务(Cloesed)与开放任务(Open)赛道的参与度“冰火两重天”——从V1.0到V1.1,前者大增了55个任务成绩,后者仅仅增加了1个,这表明更多玩家将主要精力放在了基于主流成熟模型的软硬件系统优化能力的提升。

熟悉MLPerf™基准测试的可能都知道,固定任务(Cloesed)测试要求使用相同模型和优化器,并限制Batch大小或学习率等超参数的值,衡量的是同一深度学习模型在不同软硬件上的性能表现;开放任务(Open)测试则放开了对深度学习模型及精度的约束,只会限制使用相同的数据解决相同的问题,其它模型或平台等条件都不受限制。

简言之,前者旨在对硬件和软件系统进行公平的比较,考察的是厂商对软硬件系统优化的能力;后者侧重于深度学习模型及算法优化的能力,旨在推进ML模型和算法精度的创新。很明显,前者更贴近实际AI应用环境,能够为用户从计算向智算转型升级时提供评判AI计算系统性能的更强的参考意义;后者更类似于实验室的自由发挥、充分“炫技”。

这也反映出,经过近几年的高速发展,头部厂商的AI全栈能力已经趋于成熟,它们的创新重点转向了AI的应用落地,以推动AI产业化和产业AI化,释放这一划时代通用目的技术巨大的经济价值和社会价值。

IDC的报告也印证了这种趋势。该机构预测,AI计算在整体计算市场的占比正逐年提高。作为AI基础设施的主体,全球AI服务器2020年上半年市场规模已达55.9亿美元,预计到2024年将达到251亿美元。上述冠军霸榜的浪潮信息,目前全球AI服务器市场份额第一,中国市场份额已连续五年稳居第一。

免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。