——Flink Forward Europe 2019 会议之行回顾

Flink Forward Europe 2019 于柏林时间 2019 年10月7日至9日在德国柏林如期举行。很荣幸能够在时隔两年之后和同事王唯一起以演讲者的身份再次参加 Flink Forward 大会。今年的大会是 Flink Forward 有史以来参会人数最多,演讲议题最丰富的一届。也拿到了来自Google Cloud、AWS、Alicloud、Cloudera等赞助商的金牌赞助。有趣的是,和往届不同,所有金牌赞助商都在大堂拥有了自己的展台。

本届的 Keynotes 众星云集,有来自Ververica、Google、AWS、Cloudera等的重要分享。10 月 8 日上午的 Ververica CTO Stephan Ewen 带了本届会议最重要的 Keynote 之一:Stream Processing and Applications in the Modern Age。其中他提到了 Stateful Functions 的概念——一个可降低大规模构建和协调分布式有状态应用程序复杂性的开源框架。它将 Apache Flink 流处理的优点和功能即服务(FaaS)结合在一起,为下一代事件驱动的编程模式提供了强大的抽象。

上图中左侧为事件的流入和流出,中间部分是多个 Stateful Function 负责对事件进行传递,右侧部分是对状态的 snapshot,以实现分布式有状态部署。

AWS 展示了其从 2013 年开始实现 fully managed streaming service,到2016 年支持 Flink 应用,再到 2018 年推出 Kinesis Data Analytics 平台。其中提到 Flink 是在 AWS 上发展最快的 stream processing 技术。整个分享以AWS 用户的角度出发,深刻分析了 AWS 用户的需求特点,将这些用户分为了“一般用户”(约 50% 的用户,初次接触流式计算),“大型用户”(在 AWS 运行数十个流计算应用,每天处理百亿级数据量),以及平台用户(在 AWS 运行数百个流计算应用,每天处理万亿级数据量)。不得不承认,需求促进了科技进步,而科学技术又是第一生产力。

随后 Google 也在 Keynote 中分享了从 2004 年以来对 stream processing 的经验总结。从订制的流式处理应用 windmill 到 trailing edge watermark 到 Hand tuning load variance , 再到对搜索关键词这样高 cardinality 数据的 auto scaling ,最后到如何将状态存储和实时计算分离以提高可扩展性。整个分享下来,让人不禁佩服 Google 的方法论和工程能力。

8号,9号两天下午的分会场,我们也看到了来自世界各地不同团队带来的精彩分享。其中不乏有对Flink底层技术的深度探讨;对应用场景的巧妙探索;对平台整合能力的实践;以及Flink对AI算法支持的努力。

瀚思自从两年前迁移到 Flink 平台以来,把安全分析流水线上需要的各种分析模式,包括离线分析、实时流分析、机器学习,逐步统一到一套描述语言和执行平台上。本届我们带来的议题是其中的机器学习环节,分享如何利用Flink SQL来构建整套的自动化机器学习流程。我们主要从安全分析的特殊需求着手,探讨了为何需要机器学习算法;在客户场景中我们遇到过什么问题;在实时计算流程中加入机器学习算法有什么挑战;如何利用Flink SQL构建机器学习流程;最后如何将所有步骤进行自动部署。关于以上议题的技术实现会在下期进行详细的专题分享,敬请期待。

本次四十分钟分享由我和同事王唯共同完成,期间我们现场演示了自动化机器学习编排系统,得到了听众的一致赞赏。答疑和阶段,有听众提出了关于如何动态验证,更新模型,如何自动化学习模型准确度,是否支持第三方模型导入等问题。很显然,高自动化程度的机器学习系统是未来几年的趋势,各家都在朝着这个方向努力。如何在海量数据中快速提取有效信息,更好的服务客户,为公司带来更大的收益,成为了大数据公司快速发展的必备技能。

无独有偶,阿里的实时计算团队也探讨了如何在 Flink 上构建一整套的 AI生态。其核心出发点在于如何降低机器学习,深度学习在工业层面上的实现成本。传统情况下,一个完整的深度学习流程主要包括四大步骤:数据接入 -> 数据变换 -> 模型训练 -> 模型上线服务。而这往往需要软件工程师的工程能力,数据科学家的算法能力,以及对不同系统的运维能力。很显然,即使是实现一个简单的深度学习流程,都需要多方的协作,故而难以扩展。所以从这个角度出发,阿里的 Flink 团队提出了大胆的设想:能否将所有步骤都放在 Flink 上运行?为了回答这个问题,他们正在做多方面的努力,包括:将分布式的 TensorFlow 程序运行于 Flink的 Job 之上,由 Flink 的 TaskManager 来管理资源分配;通过梯度计算对算法模型进行验证,动态更新;对 Python 算法库的更好的支持。最终的成果都会贡献给社区。

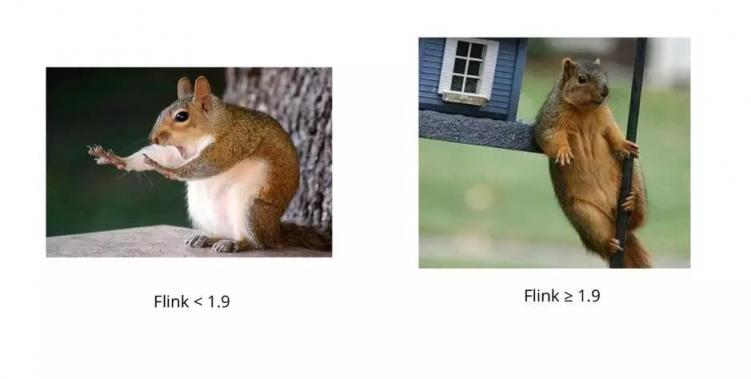

纵观本届的主要议题,可以看到核心痛点集中在如何降低流式应用的开发维护成本,尤其是如何将流式计算与 AI 算法相结合来满足日益增长的业务需求。为了这个共同的目标,整个 Apache Flink 团队在过去半年的时间里修复了 2000 个左右的 PR ,为我们带来了具有质的飞跃的 Flink 1.9.1。Stephen 也很幽默的在其演讲稿中贴上了 Flink 吉祥物的两张贴图以作对比:

最后,再次祝贺本次Flink Forward Europe 大会圆满成功,同时期待今年11月份在北京举行的 Flink Forward Asia 。

- ChatGPT推出图片管理功能:AI创作更高效!

- 长安汽车新布局:今年推出20款新车,未来5年50款,全面发力新能源汽车市场

- 抢票关键时刻12306崩溃,网友呼唤客服解难

- 极石汽车创始人套现9亿后清空社交账号,反劝投资者耐心,引发深思

- OpenAI成立非营利委员会:揭秘四大顾问背后的新发展

- 抵御关税冲击,美国PC市场2025年Q1逆袭:出货量激增12.6%,库存量将大增

- 哈啰出行如何破解资金难题:借贷策略揭秘

- 全球电车风潮涌动:中国与欧洲领跑,同比增长29%的电动汽车销量新篇章

- 货拉拉五次冲击港股IPO:营收增长19%却估值跌回四年前,上市之路坎坷不前

- DeepSeek助力AI原生App:月活跃用户数翻番,开启智能新纪元

免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。