全球AI的顶级盛会GTC于3月17日到3月21日在美国硅谷盛大举行。在GTC大会期间,华瑞指数云ExponTech CTO曹羽中受邀参加了专注于AI Storage的技术研讨会并发表演讲。在演讲中,曹羽中介绍了ExponTech与合作伙伴ScaleFlux, AIC基于英伟达的BlueField3 DPU以及英伟达最新发布的Spectrum-X网络打造的新型AI Storage方案,展示了该方案的实际测试数据,并与合作伙伴,AI Storage行业专家以及一些大型客户进行了深入讨论。与会的专家均表示该方案的实测性能数据以及综合优势表现远超预期,具备很高的商业价值,very impressive!

新型AI存储方案采用的软硬件方案:

硬件:

F2026 AI服务器,是一台2U闪存JBOF,配备2个或4个NVIDIA BlueField-3数据处理单元(DPU)和24块高性能ScaleFlux CSD5000 NVMe SSD(CSD5000是ScaleFlux公司最新推出的一款内置硬件压缩与解压缩能力的高性能NVMe SSD介质);

NVIDIA Spectrum-X网络交换机;

软件:

华瑞指数云ExponTech下一代分布式存储软件平台WADP (WiDE AI Data Platform);

(本方案采用的2U存储节点及ScaleFlux CSD5000 NVMe SSD)

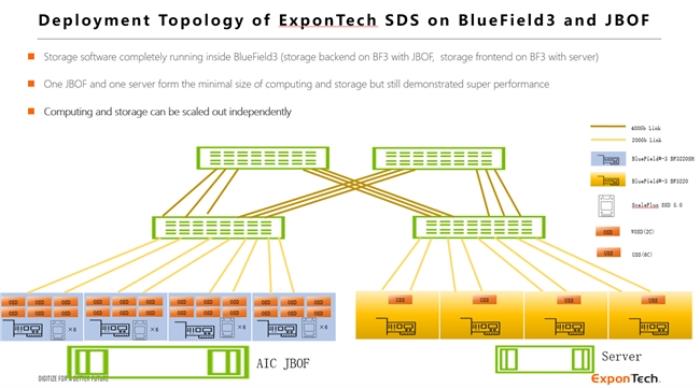

基于此方案的AI训练和推理环境的实测部署架构如下图:

1台2U AIC JBOF作为存储服务器, 配备4块NVIDIA BlueField3 DPU, 提供1600Gbps网络带宽,24块ScaleFlux CSD5000 NVMe SSD,ExponTech WADP存储软件的后端运行于BlueField3 DPU内;

1台标准2U服务器作为计算服务器,配备4块NVIDIA BlueField3 DPU,提供800Gbps网络带宽,在DPU内部运行ExponTech WADP存储软件的存储网关和协议;

计算服务器上可以配置GPU,用于训练或推理,存储软件和网络流量运行于DPU内,存储IO不会消耗计算服务器的CPU和内存资源,计算服务器可以拥有更充沛的资源用于计算处理;

测试环境特别选择了4台NVIDIA Spectrum-X交换机组成两层网络,主要是为了模拟与验证在大规模组网的情况下,RoCE网络是否依然可以很好的处理拥塞,存储软件可以依然保持稳定的存储性能和低时延;

存储服务器(JBOF)和计算服务器均可以按需独立扩展,按需加入更多的存储服务器(JBOF)或者计算服务器,构成大规模的,存算分离的,按需扩展的AI训练和推理集群。

基础存储性能验证:

基于上一节所述的实测部署环境,进行了存储系统的基础性能验证,其验证方法是从计算节点上运行FIO,测试存储系统的基础性能指标。

单个计算节点可以达到近90GB/s的存储带宽,接近计算节点网卡的物理带宽上限;

单个计算节点可以达到310万IOPS,当配置更多的计算节点时,可以同步获得更多的IOPS。考虑到整个存储系统的后端以及协议端都是跑在DPU内,DPU内的CPU处理性能远远不如服务器配置的CPU,单个计算节点+单个存储节点即达到310万IOPS已经充分展现了本方案相当惊人的IO处理效率;

存储系统的IOPS与存储节点上部署的数据处理单元(DPU)数量呈线性比例扩展,系统的IOPS随DPU部署数量线性扩展,表明其具备极佳的横向扩展能力。本方案采用的存储节点最多可以配置8张DPU(当前测试环境配置4张),还可以实现IOPS性能翻倍以及网络带宽翻倍;

存储系统在使用小IO size时,并发大压力时延低至266us, 在使用大IO size时,打满计算节点的网络物理带宽,时延还能始终保持在1毫秒以下。

MLPerfStorage v1.0测试结果:

MLPerf™ 是影响力最广的国际AI性能基准评测,MLPerf™ Storage是针对AI Storage的基准性能测试,可以较为全面的评估测试AI应用程序的存储需求。MLPerf™ Storage基准测试通过运行一个分布式训练测试程序,模拟GPU计算过程,在此过程中真实的执行AI服务器对存储系统的读写访问,以此来测试存储系统能够支撑的最大GPU数量和带宽表现。

MLPerf Storage v1.0于2024年8月推出,国内外一共有十三家从事高性能存储研发的厂家参与了测试并提交正式测试结果,其中包括DDN(Lustre),华为,WekaIO,Hammerspace等知名的分布式文件系统厂家。

本次我们选择了ResNet50模型(主要用于图像分类和图像识别场景),在上述1存储节点(JBOF)+1计算节点的测试环境上进行了MLPerf Storage v1.0基准测试,测试的结果如下:

测试结果表明:

ExponTech的新型AI存储方案具备全球领先的性能,单客户端能够支持的GPU卡的数量超过了所有参与了MLPerf Storage v1.0正式测试的厂商,位居全球第一;单客户端能够实现的存储带宽达到近30GB/s,位居全球第二;本次测试环境只有一个客户端节点(计算节点),CPU和内存配置较低,在运行MLPerf Storage v1.0的测试中已经达到了客户端节点的计算能力的瓶颈,但是还远远没有达到存储节点的存储能力的瓶颈。如果换用处理能力更强的计算节点来做测试,可以测试出更高的性能数据,即支持更多的GPU卡,实现更高的存储带宽。

总结

基于本次在真实的环境上的全面测试,总结一下ExponTech与合作伙伴ScaleFlux, AIC基于英伟达的BlueField3 DPU以及英伟达最新发布的Spectrum-X网络打造的新型AI Storage方案的关键特点和优势:

世界顶级性能,SPC-1 评测超越所有高端全闪存储阵列,打破世界纪录,MLPerf Storage v1.0测试数据大幅度超越WekaIO, DDN等著名并行文件系统;

世界顶级容量密度,当前每2U Storage Node可实现超过1.6PB存储裸容量,明年可扩展至每2U超过6.6PB,最大化数据中心空间的AI数据价值;

配置的ScaleFlux CSD5000 NVMe SSD具有盘内透明压缩解压缩能力,能够在不消耗额外系统资源,不影响性能的情况下实现存储裸容量的数倍放大,存储容量效率获得惊人的提升;

同一平台上同时支持高性能分布式块存储和文件存储等多种协议,除了支持AI的训练和推理场景,还可以覆盖数据汇集,数据准备,RAG等AI Pipeline全场景,无须为AI Pipeline配置不同的存储方案以及反复进行数据拷贝移动,可以实现AI算力和存力的完全存算分离和独立扩展,具备更好的可管理性和效率;

强大的并行扩展性,存储节点及计算节点均可以独立的水平扩展,同时实现存储性能和容量的等比例扩展;

可靠性高,可维护性高,存储节点采用相比标准服务器更为精简的JBOF,硬件故障率更低,同时JBOF内部采用冗余的硬件设计来保障可靠性,提升可维护性;

支持基于RoCE的超大规模组网,采用RoCE动态路由和细粒度的负载均衡实现更好的拥塞控制,基于标准以太网在大规模RDMA组网中实现高效带宽, 低抖动和超低时延;

优化的总体拥有成本(TCO),高密度的存储节点+透明盘内压缩+新型软件定义存储软件的组合简化了硬件成本,大幅度提升了存储空间利用效率和读写性能,简化了管理,AI客户将因此大幅度优化其AI Storage的总体拥有成本(TCO);

基于此方案的KV Cache大规模持久化方案也即将推出,实现AI推理集群内的K,V向量的全局共享,能够以低成本高性能的大规模存储能力替代AI推理过程中K,V向量的大量重复运算,实现AI推理算力成本的大幅降低。

(免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。 )