提示工程是一种在机器学习模型,尤其是预训练语言模型中,通过精心设计输入提示(prompt)来引导模型输出期望结果的技术。在大语言模型的使用中,提示词通常是一段文本,用来引导模型生成特定的输出或完成特定的任务。

在多文档搜索、问答系统、文档自动摘要生成以及阅读理解等多样化且复杂的应用场景中,往往会面临输入提示(prompt)长度显著增加的挑战。这种超长prompt不仅加大了大型语言模型(LLM)的推理成本,还显著延长了推理时间,从而严重限制了其在需要即时响应的实时应用场景中的适用性。为了克服这一难题,优化prompt设计,如通过压缩技术精简关键信息、采用更高效的prompt格式或结构,变得尤为关键。这样的策略旨在平衡模型性能与实时性需求,确保LLM能够在复杂多变的场景下依然保持高效、准确的响应能力。

基于以上背景,卓世科技创新的中文提示词压缩技术应运而生。

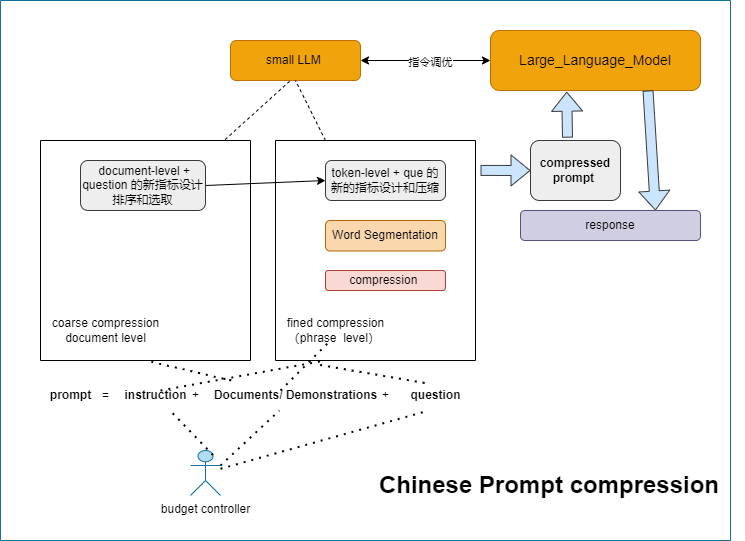

卓世科技对提示词进行压缩的技术旨在保证推理效果的前提下降低推理成本,提升推理速度。其主要的思路如下:

(1)定义长prompt的结构:

Prompt=instruction+documents/demonstrations+question。

(2)小语言模型和大语言模型的分布对齐

使用小语言模型(small LLM)估计长prompt的各个部分的重要程度,为了缩小大语言模型(LLM)和小语言模型之间的概率分布差距,通过在LLM生成的数据上进行指令微调来有效小语言模型,使得小语言模型更好地模拟LLM的分布。

(3)对documents/demonstrations部分进行两个层次的压缩。

3.1、示例层次的压缩

documents/demonstrations部分中通常包含多个文档/示例,而每个文档/示例包含有多个段落。针对每个文档/示例的每个段落,计算出段落与question的相关性,保留得分前3的段落作为该文档/示例的代表上下文x_doc。同时,可计算出该文档/示例中所有段落的平均相关性s_k。

然后根据question部分和文档/示例的代表上下文x_doc计算文档/示例级别的困惑度r_k。最终文档/示例的评分为s1=s_k*r_k。

此时,每个文档/示例计算出三个分数,评分s1、平均相关性s_k以及困惑度r_k。利用这三个分数从长prompt的documents/demonstrations部分中删除部分文档/示例。

3.2重排序

由于模型对prompt的不同位置处的信息的敏感度不同,通常模型对prompt首尾位置处的信息敏感度较好,中间位置的敏感度较差。为了确保prompt的效果,可依据评分对保留的文档进行重排序处理,使得评分较高的文档排列在首位,评分较低排列在中间位置。

3.3文档/示例压缩率计算

针对重排序后的prompt,用户可自定义在词语层次上的压缩率。按照上述文档/示例的排序,使用[1, 2*Kc]的均匀离散分布,来初始化每个文档/示例的压缩率。

3.4词语层次的压缩

在删减文档/示例后的documents/demonstrations部分,可计算每个token的条件困惑度差异。

为了确保压缩后的语义完整,可使用双向最大匹配分词法,以获取到最长的分词词语。同时,为了适应垂直领域,可结合垂直领域内的专业词汇表进行分词,尽量保留垂直领域内的专业词汇。

然后可基于前述计算出的token的条件困惑度差异以及分词的结果,对每个词语进行打分。假设一个中文词语word_i有k个token组成,按照该中文词语word_i是否属于垂直领域的词汇,使用不同的计算方式对其评分。

最后针对每个文档/示例,利用文档/示例中每个词汇的评分,按照得分高低顺序压缩文档/示例,使得其满足文档/示例的压缩率。

(4)压缩后的prompt可输入至大语言模型中,得到响应。

至此,整个提示词压缩的方案介绍完毕,该技术方案相比于其他压缩方案,更加适配中文的词语粒度,尤其在垂直领域可避免丢失专业词汇,在保证语义完整的情况下删减了冗余信息,可有效降低提升推理效率,节约计算成本。

(免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。 )