近日,德国专业汽车行业杂志HANSERautomotive就浪潮信息算法团队在自动驾驶领域所取得的核心突破,进行专题署名文章报道“Wahrnehmungssysteme und 3D-Objekterkennung Alles im Blick”(《感知系统和三维物体识别,一切尽收眼底》)。针对AI感知技术对于自动驾驶产业化落地的变革式意义,《HANSERautomotive》文章指出,“3D目标检测作为自动驾驶领域至关重要的核心任务,面向强大的环境感知,先进的AI算法及融合架构感知技术,为实现高鲁棒、高精度的目标检测提供了至关重要的信息输入,平台算力和感知算法的效率提升与创新突破,也成为了车企发展自动驾驶能力的关键技术。”

目前,在全球权威的自动驾驶nuScenes竞赛最新评测中,浪潮信息算法团队所提交的“IEI-BEVFusion++”算法模型在关键性指标nuScenes Detection Score(NDS)得到77.6%的高分,创造了3D目标检测全赛道迄今最高成绩。

【HANSERautomotive作为德国Top级汽车电子行业媒体,旨在持续赋能汽车电子开发、项目、应用和测试领域的工程师,为全球汽车领域的行业高管与最重要的利益相关者,提供产品、系统、趋势和时事,在电信/数据通信、消费和工业等行业领域做出更好的决策。】

附《HANSERautomotive》详细报道(原文译释): 自动驾驶将从头开始改变移动行业,是汽车制造商和人工智能公司关注的重点领域。自动驾驶技术的核心是基于算法的 3D 物体识别,它被认为是自动驾驶汽车环境感知的核心。至关重要的是,车辆使用各种传感器来估计其环境中人、车辆和物体在三维空间中的距离。以下文章解释了不同传感器的工作原理以及它们之间的交互方式。自动驾驶核心感知任务——3D目标检测从自动驾驶分类来看,目前的自动驾驶技术有两大类。一种是以直接达到Level 4(高度驾驶自动化)为目标的激进派,另一种是从Level 2(辅助驾驶)逐步提升自动驾驶等级的渐进派。但无论是Level 2还是Level 4,从整体架构来看,大致可以分为感知、决策和控制三个部分。感知是自动驾驶汽车的眼睛,犹如人类的眼睛为大脑提供 70% 以上的信息类似,感知系统也为自动驾驶汽车的外部环境提供信息。自动驾驶的感知依赖于各种传感器的信息,包括摄像头、雷达、激光雷达等,其中最核心的就是相机和激光雷达。自动驾驶面对的是一个3维的环境空间,甚至我们可以这么说,因为自动驾驶车辆要在环境空间中移动,且环境空间中其他的行人、车辆也会移动,可见自动驾驶面临的是一个4D时空系统(3D空间+1D时间)。自动驾驶汽车需要在三维空间中判断周围人、车、物之间的距离。在此基础上,还需要判断它们是静态的还是动态的,以及移动的方向和速度等信息,我们一般称之为3D目标检测任务。 3D物体检测任务可以看作是自动驾驶中的最核心感知任务。当然,除此之外,其他感知任务还包括识别红绿灯、交通标志、车道、斑马线等道路信息。

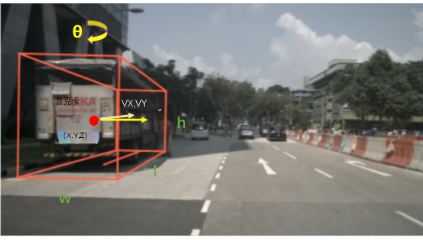

(图注:3D 目标检测图。 3D目标定义为一个盒子,(x,y,z)为盒子的中心坐标,(l,w,h)为长宽高,θ为航向角。 Class 是 3D 目标的类别。 Vx 和 vy 描述了地面上 3D 目标沿 x 和 y 轴的速度。)

传感器:激光雷达长期以来,激光雷达一直被认为是自动驾驶汽车不可或缺的部件之一,因为激光雷达可以提供车辆周围环境最准确的3D感知。激光雷达采集到的点云信息天然就存储着3D空间信息,因此对于基于点云信息的3D目标检测来说,算法设计就简单很多,也诞生了一系列的经典模型,如PointPillar、SECOND、SSSD等。然而,激光雷达的成本也成为了自动驾驶落地的最大瓶颈,激光雷达比汽车贵的问题,成为其上车和量产的最大障碍。虽然这些年激光雷达的价格随着技术的进步有了明显的下降,但是能够满足L4需求的激光雷达的价格还是偏高。

传感器:相机摄像头是自动驾驶汽车的另一个非常重要的传感器。由于激光雷达采集的点云信息没有颜色和纹理,无法识别红绿灯、交通标志、车道、斑马线等人类容易识别的道路信息。因此,仍然需要摄像头作为辅助传感器。但是,这会导致多模态的信息融合问题。简而言之,激光雷达主要擅长对车辆和行人的3D信息的感知,而摄像头擅长于对红绿灯、车道线等具有丰富视觉纹理特征的信息的感知。此外,相机在量产成本和价格方面也具有无可比拟的优势。例如,特斯拉搭载的单个单目摄像头成本仅为25美元,整车8个摄像头的价格仅为200美元。仅使用相机传感器,借助强大的人工智能算法,可以实现精确的3D物体检测任务,这意味着不使用激光雷达传感器的自动驾驶成为可能。基于图像的3D目标检测算法在计算机视觉领域,近年来涌现了大量的分类、检测、分割模型,如ResNet、YOLO、Mask RCNN等,这些AI模型已广泛应用于安防、交通、和自动驾驶。然而,核心问题之一是这些模型是为 2D 图像设计的,不能直接应用于 3D 对象检测任务。基于图像的3D物体检测的核心问题是如何准确估计图像中物体的深度。由于相机拍摄的照片和视频将3D空间投影到2D平面,丢失了深度信息,如何恢复深度信息是一个“病态问题”。也就是说,问题的解决方案可能不是唯一的。因此,长期以来,基于图像的3D目标检测算法的性能一直远低于基于激光雷达的3D目标检测算法。自从特斯拉仅使用摄像头的FSD驾驶系统取得了一定的成功后,基于视觉的自动驾驶感知方案就越来越受到业界的关注。同时,随着数据、算法、算力等方面的进步,纯视觉自动驾驶感知方案在3D目标检测任务中的性能较去年的激光雷达有明显提升。NuScenes 数据集自动驾驶数据集的出现时间更长,传感器更多,采集时间更长。 NuScenes 数据集由 Motive 于 2019 年开发并发布,采集于波士顿和新加坡街头。为了获取有意义的场景数据,我们收集了大约 15 小时的驾驶数据,并精心选择了涵盖不同场景的驾驶路线。采集车搭载传感器,包括6个摄像头、1个激光雷达、5个毫米波雷达、GPS、IMU,具有360°视场感知。

(图注:安装在 NuScenes 数据集采集车上的传感器放置位置图。它配备了6个摄像头、1个激光雷达和5个毫米波雷达。)

NuScenes 数据集提供了几个评估任务,包括 3D 对象检测、3D 对象跟踪、预测轨迹、激光雷达分割、全景分割和跟踪。 3D 物体检测任务的目标是检测 NuScenes 数据集中的 10 种不同类型的检测物体,包括汽车、卡车、自行车和行人。检测信息除了物体的三维位置外,还包括物体的大小、方向和速度。 NuScenes提出了一个综合的NDS指标,即NuScenes Detection Score(NDS),它由平均准确度(mAP)、平均平移误差(ATE)、平均尺度误差(ASE)、平均方向误差(AOE)、平均速度误差组成(AVE) 和平均属性误差 (AAE)。

(图注:NuScenes 数据集中六个摄像头采集的图像示意图。)

除了NuScenes,业界还有Waymo、ONCE等开源数据集。然而,NuScenes 是目前使用最多的数据集。自发布以来,NuScenes 数据集已被 2000 多篇研究论文引用。 NuScenes Challenge也成为测试感知算法在自动驾驶相关任务中表现的试金石。它吸引了来自世界各地的研究团队提交的 220 多份论文。近期,PhiGent Robotics、纵目科技、ECARX等车企的研发团队也出现在了NuScenes的名单中。‘

NuScenes提供了一个常年更新的榜单,目前一共有50余次提交,其中大多数的提交发生在2022年。目前全榜单排名第一的则是浪潮信息算法团队所提交的“IEI-BEVFusion++”算法模型,关键性指标nuScenes Detection Score(NDS)0.776的高分,创造了3D目标检测全赛道迄今最高成绩。

另外,在纯视觉赛道,算法团队在2022年所提交的“DABNet4D”模型,综合检测精度NDS 0.624的检测效果也一举登顶届时该赛道的榜首。相比之下,2022年初排名第一的BEV3D算法的NDS精度是0.474,也就是说在不到一年的时间内,NuScenes 纯视觉3D目标检测的NDS指标提升了15个点。基于纯视觉算法和激光雷达算法的精度差距也从年初的45%缩小到17%,而这些,均得益于纯视觉3D检测算法优化带来的性能提升。

展望未来在自动驾驶落地的产业化进程中,感知技术作为自动驾驶的核心技术模块,既是起点也是基石。而未来,面向自动驾驶感知算法的研发,也将会投入更为强大的人工智能计算平台予以支撑。从NuScenes榜单技术的快速迭代来看,我们有理由相信,随着算力、算法的持续型突破,自动驾驶产业化落地进程也将多一层“腾飞动力之源”。

(免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。 )