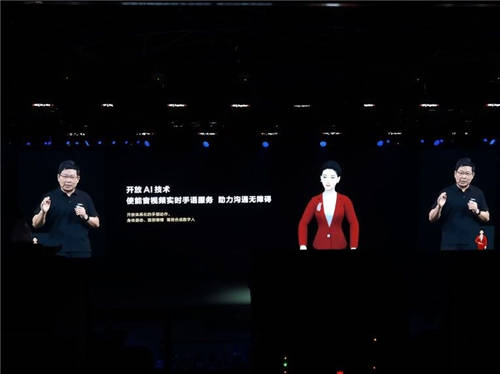

在2021年10月22日华为开发者大会的直播中,有一位红衣女孩一直在直播屏幕左下角,兢兢业业地为整场大会做实时手语翻译。这位红衣女孩是HMS Core团队的手语数字人,她基于团队最新研发的手语服务,可以完成实时手语翻译,生成包括身体姿态、手部动作以及面部表情的手语。有了她,听障手语使用者也可以“听”懂HDC大会,获取到更多感兴趣的资讯。这是华为首次采用AI全程手语直播,引发了线上线下观众和媒体的关注。

一个美好的愿望

手语项目起源于一款在2018年推出的应用StorySign,这是一个将欧美流行儿童书籍转化成手语动画,帮助有听力障碍的儿童学习阅读的App。StorySign的推出为众多听障儿童打开了连接世界的一扇窗,也给他们的家庭带去了温暖。发布一段时间后,StorySign逐步上架了71本儿童读物,支持了英、法、德等15种语言的手语,但同时项目也遇到瓶颈:想要普及手语,让更多的人学习更丰富的手语,就要有充足的手语动画作为手语学习的资源。但如何更快速地生成丰富的手语动画呢?

StorySign集成了HMS Core的OCR(Optical Character Recognition, 光学字符识别)技术,这是一种基于深度学习,将图片上的文字智能识别成文本的AI技术。那么,既然AI可以智能识别图片上的文字, AI能不能做手语翻译呢?给AI一段话,它如果可以自动翻译成手语动画,大家就可以跟着AI学习手语了,甚至AI也能成为聋人与健听人之间的实时翻译官,这样AI造福的不仅仅是儿童的阅读场景,更是更广泛的听障群体!

为了让AI手语翻译通过HMS Core能力开放出去,让开发者去集成,进而服务到全球4.6亿的听障人群。首先要面对的难题便是 - AI能不能做手语翻译,从文字智能生成手语动画?HMS Core组建了覆盖AI手语翻译所需要的3D数字人建模、自然语言理解、计算机视觉、3D动画、图形渲染、移动端Android开发、云侧服务化等众多关键技术专家团队,并邀请到国内权威手语语言学专业教授作为项目顾问,携手共同攻关智能实时手语翻译项目。

算法和数据的双重挑战

手语翻译项目启动后,团队通过查阅大量文献和专利,快速对行业内相关技术进行了调研,一起梳理出了几大难题。首先,要考虑到手语动作对于精度的高要求,1厘米指尖位置的误差就可能表示完全不同的意思。其次,中文和手语成对的大规模高质量手语语料极难获取,无法在短时间内找到这么多专业的手语老师来提供语料。第三,手语作为独立的语言,有其自身的语法及语序,中文与手语的语法及语序存在差异。例如中文“我没有带身份证”,对应的手语语序为“身份证/我/带/没有”。最后,手语不仅包括手部动作,还包含身体姿态及面部表情和口动,多模态数据的协同生成很重要。

通过对这些难题的逐一分析与解决方案的讨论,手语团队输出了一种基于文本的多模态数字人动作和表情生成方案。这个方案由手语转写模块和手语动作表情生成模块组成,融合了手语语言学领域知识,并且能够有效解决高质量动捕数据较少的问题。

算法方案确定后,手语团队迎来了更大的挑战——数据。在人工智能领域,有句话是“兵马未动,粮草先行”,对手语翻译项目来说,“粮草”就是手语数据获取问题,包括手语转写数据和3D动作数据。如何制定合理的转写方案?什么样的动作捕捉设备采集的数据可以满足手语项目的商用要求?

转写是一件需要紧密结合语言学和计算机学的工作。为此,技术专家们与手语顾问紧密配合,投入到手语语言学知识学习中,经过了大量的讨论,制定适合项目的手语转写标准。语言本是一件语感驱动的事,而计算机则是讲究规则的。为了将手语语言学的知识总结成计算机能表达出的规则,团队里的人工智能专家们和手语顾问对转写规则进行了多次讨论,反复修改优化了20多个版本,最终完成了适合项目要求的定制化转写方案。

在动作捕捉数据方面,通过多方调研以及对动捕设备现场考察,过数十种之后,手语团队发现发现,动捕数据采集情况远比想象的复杂得多。在动捕采集的过程中,可能引入误差的原因有很多,例如动捕服不够贴身、动捕人员身型比例与手语数字人比例不一致等,导致动捕的原始数据无法直接使用。因此,手语团队立刻组建动作修复小组,加快动捕数据的采集进度,使项目得以稳步推进。

手语数字人和开发者大会的故事

随着数据采集进度的推进和AI算法模型的迭代优化,手语服务的工程化也同步进展顺利。手语翻译团队在短短一周的时间内就写完了移动端SDK开发代码,并且顺利地完成了端云联调。同时,在尝试了多种不同的解决方案后,手语翻译团队通过旋转角直接驱动骨骼的方式,避免在驱动后数字人动作的微小差别导致手语意思相差甚远,让手语数字人能够准确地完成手语动作

一切就绪,手语服务准备开放首版本,在HDC交出一份满意的答卷。手语团队决定让手语数字人全程支持开发者大会直播演讲。这个挑战可想而知,华为开发者大会上直播,观看的人数非常庞大。如果手语数字人可以登上这个舞台,在直播时为听障朋友们提供手语翻译,所有观看直播的人都会注意到这个会打手语的红衣女孩。这无疑可以吸引更多人来关注听障人士,也就可以吸引到更多开发者借助手语服务来为听障手语使用者提供服务。

手语服务是从文本生成手语,直播时算法的输出严重依赖于语音识别的结果,语音识别的准确性如何保障?HDC大会演讲中包含大量中英文混合的技术名词,怎么让手语数字人打出这些词?把整套驱动和渲染方案搬到自研引擎上能否兼容?面对这些棘手的问题,手语团队组建了HDC大会直播攻关小组,一部分成员攻关算法,在优化手语生成算法模型以覆盖HDC大会可能会出现的科技语料;另一部分成员攻关直播时云上语音识别、文字转手语算法部署以及3D模型驱动问题,以保证直播时手语数字人能顺利识别到话筒中的声音并打手语。在不到一个月的时间里做足了充足的准备。

在HDC2021如约举办的当天。手语团队的伙伴们在后台紧张地守着直播画面,他们紧紧盯着直播屏幕左下角的红衣女孩,担心手语数字人出现任何故障。所幸在整场直播中,她表现得游刃有余,非常惊艳!这一刻,团队所有人的心情都是一样的:不懈的努力没有白费,手语数字人终于在HDC这个大舞台上被大家看见了!

这是国内首次由数字虚拟人物进行的实时大会直播手语翻译,这一切都得益于华为自研的AI算法以及渲染技术,让大会直播实时手语翻译在完全无需真人的情况下得以实现。这套基于云技术的语音识别、手语生成、驱动渲染的手语翻译方案经过HDC2021得到了验证,它不仅准确呈现了手语动作,也解决了手语翻译目前普遍的的一个技术难点——表情系统。表情的出现让手语数字人能够更加完整准确地表达手语含义,目前手语服务已支持输出10种不同的表情类型。相信在不久的将来,这套方案可以被搬上媒体内容制作中,听障朋友们也可以获取更多的社会资讯。

技术传递温度

全球有4.6亿听障人群,当前的中文手语生成远远不足以覆盖这些人群。未来,HMS Core手语团队将持续优化手语翻译效果和手语数字人渲染效果,同时也将构建英文手语生成能力,将手语服务全球化,以服务更多的听障人群。

相信在不久的将来,手语数字人可以在更多的场合和大家见面,她可以出现在电视新闻节目的手语翻译小窗口中,为大家翻译新闻;也可以在大家乘坐地铁、飞机的时候,可以用手语为听障朋友们播报安全须知;甚至,在一些特殊教育学校里,她可以做一位手语老师,教听力障碍的同学们学习手语……。怀揣着这个美好的愿望, HMS Core团队基于手语服务能力正在打造StorySign2.0 APP,希望能带给听障人士更多的温度。

正如HDC大会上的一句话:没有人能够熄灭满天星光,每一位开发者,都是华为要汇聚的星星之火。目前,手语数字人已经通过HMS Core手语服务向开发者全面开放,让更多的应用开发者都可以通过调用我们的手语服务SDK,快速实现手语实时翻译,打造各类手语App,为听障人士提供更加多样化的服务。手语服务团队希望和开发者一起,共筑华为移动服务的满天星光,打造一个沟通无障碍的世界。

文章转自《华为人》

(免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。 )