Meta创新SWEET-RL框架:AI理解人类意图再升级,开启智能新篇章

随着科技的飞速发展,人工智能(AI)在各个领域的应用日益广泛。近日,Meta AI公司携手加州大学伯克利分校,推出了一种名为SWEET-RL的强化学习框架,这一创新性成果将进一步推动AI技术的发展,开启智能新篇章。

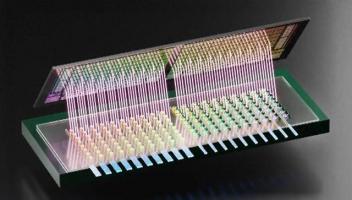

SWEET-RL框架的核心在于通过强化学习来提升大语言模型(LLMs)在多轮人机协作任务中的表现。特别是在后端编程和前端设计领域,这一创新为复杂任务的执行提供了新的可能。通过逐轮优化决策,SWEET-RL显著提高了模型的任务完成率,并展示了其在开源模型与专有模型竞争中的潜力。

在项目背景方面,大语言模型正逐渐演变为能够执行复杂任务的自主智能体,但在多轮决策任务中仍面临挑战。传统的训练方法依赖于单轮反馈或模仿高概率行为,无法有效处理长期依赖和累积目标。这导致模型在协作场景中表现不佳,特别是在理解人类意图和多步骤推理方面。而SWEET-RL的出现,为解决这一问题提供了新的思路。

SWEET-RL的创新之处在于其采用了非对称的“演员-评论家”结构。在这个结构中,“演员”负责执行决策,而“评论家”则可以在训练过程中访问额外信息,如正确答案,从而更精确地评估演员的决策。这种结构直接建模了逐轮的优势函数,简化了信用分配过程,并与LLMs的预训练架构更好地对齐。

实验结果显示,SWEET-RL在后端编程任务中的通过率提升至48.0%,前端设计任务的余弦相似度达到76.9%,显著优于其他多轮强化学习方法。这一创新性的成果不仅提高了模型在多轮任务中的表现,也展示了其在真实场景中的广泛应用前景。

为了进一步验证SWEET-RL的效果,Meta AI公司还发布了CollaborativeAgentBench(ColBench)基准测试。ColBench包含超过10000个训练任务和1000个测试案例,模拟真实的人机协作场景。任务设计涵盖了后端编程(如Python函数编写)和前端设计(如HTML代码生成),并限制每轮交互最多10次。这一基准测试通过单元测试通过率(代码)和余弦相似度(设计)评估模型表现,为多轮任务提供了可靠的评估标准。

值得一提的是,ColBench的设计充分考虑了人机协作的真实场景,为AI模型提供了更全面的挑战。在ColBench的测试案例中,模型需要处理多步骤推理、理解人类意图、以及在长期依赖中做出决策等问题。这些问题也是当前AI技术面临的难点,而SWEET-RL的优异表现表明,它已经具备了解决这些问题的潜力。

总的来说,Meta AI公司与加州大学伯克利分校的合作成果SWEET-RL框架,无疑为AI技术的发展打开了一扇新的大门。通过强化学习的方法,SWEET-RL能够更好地理解人类意图,并在多轮任务中表现出色。这一创新性的成果将推动AI技术在各个领域的应用,为人类社会的发展带来更多的可能性。我们期待着AI技术的进一步发展,相信它将在未来为我们带来更多的惊喜和改变。

(免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。 )