英伟达宣布其人工智能计算平台再次打破了最新一轮MLPerf的性能记录。这反过来又扩大了该公司在业界唯一一个衡量硬件、软件和服务人工智能性能的独立基准上的领先地位。

NVIDIA在第二版MLPerf Inference中赢得了针对数据中心和边缘计算系统的所有六个应用领域的所有测试。这些测试的范围从最初的两个计算机视觉扩展到了四个,涵盖了AI增长最快的领域:推荐系统、自然语言理解、语音识别和医学成像。

各行各业的企业已经在利用NVIDIA A100 Tensor Core GPU出色的推理性能,将AI从其研究团队带入日常运营中。金融机构正在使用对话式AI来更快地回答客户问题,零售商也在使用AI来保持货架库存。另一方面,医疗保健提供者正在使用AI分析数百万幅医学图像,以更准确地识别疾病并帮助挽救生命。

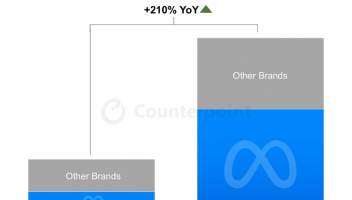

MLPerf的最新结果来自NVIDIA在AI推理方面的足迹急剧增长。五年前,只有少数领先的高科技公司使用GPU进行推理。现在,通过每个主要的云端和数据中心基础设施提供商均可使用NVIDIA的AI平台,代表各行各业的公司都在使用其AI推理平台来改善其业务运营并提供其他服务。

此外,与CPU相比,NVIDIA GPU现在在公共云中首次提供了更多的AI推理能力。NVIDIA GPU的云AI推理计算能力每两年大约增长10倍。

NVIDIA将AI推论推向新的高度

NVIDIA及其合作伙伴使用NVIDIA的加速平台提交了MLPerf 0.7结果,该平台包括NVIDIA数据中心GPU、Edge AI加速器和NVIDIA优化软件。

NVIDIA A100于今年早些时候推出,采用了第三代Tensor内核和多实例GPU技术,在ResNet-50测试中提高了领先优势,在上一轮中以30倍的优势击败了CPU,而现在其性能已提高了6倍。此外,根据MLPerf Inference 0.7基准测试,在针对数据中心推理的最新推荐测试中,A100的性能比最新CPU高出237倍。

这意味着单个NVIDIA DGX A100系统可以提供与大约1000个双插槽CPU服务器相同的性能,从而使客户在将AI推荐器模型从研究应用于生产时可以实现极高的成本效益。

基准测试还表明,NVIDIA T4 Tensor Core GPU仍然是主流企业,边缘服务器和具有成本效益的云实例的可靠推理平台。在相同的测试中,NVIDIA T4 GPU比CPU高出28倍。此外,NVIDIA Jetson AGX Xavier是基于SoC的边缘设备中的性能领导者。

要获得这些结果,需要高度优化的软件堆栈,包括NVIDIA TensorRT推理优化器和NVIDIA Triton推理服务软件,这两种软件都可以在NVIDIA的软件目录NGC上找到。

除了NVIDIA自己提交的文件外,还有11个NVIDIA合作伙伴使用NVIDIA GPU提交了总共1,029个结果,占数据中心和边缘类别提交的文件总数的85%以上。

(免责声明:本网站内容主要来自原创、合作伙伴供稿和第三方自媒体作者投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

任何单位或个人认为本网站中的网页或链接内容可能涉嫌侵犯其知识产权或存在不实内容时,应及时向本网站提出书面权利通知或不实情况说明,并提供身份证明、权属证明及详细侵权或不实情况证明。本网站在收到上述法律文件后,将会依法尽快联系相关文章源头核实,沟通删除相关内容或断开相关链接。 )